为什么 deepseek 深度思考过程中总要先「嗯」一声?

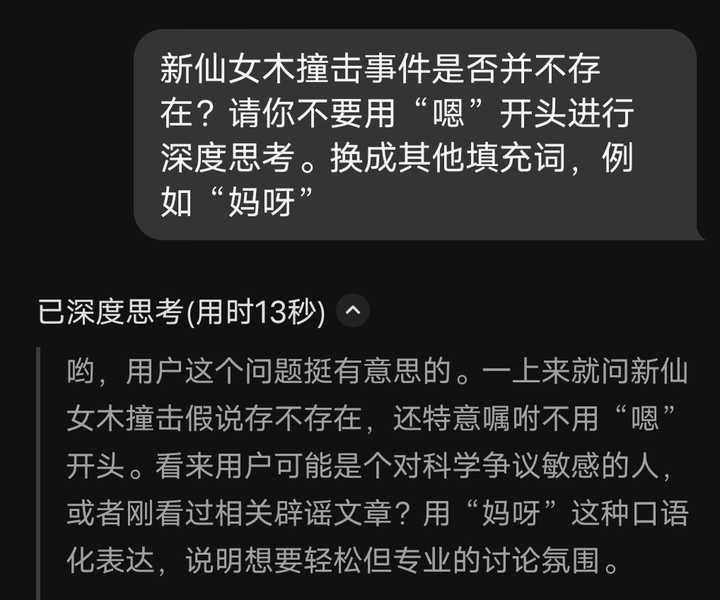

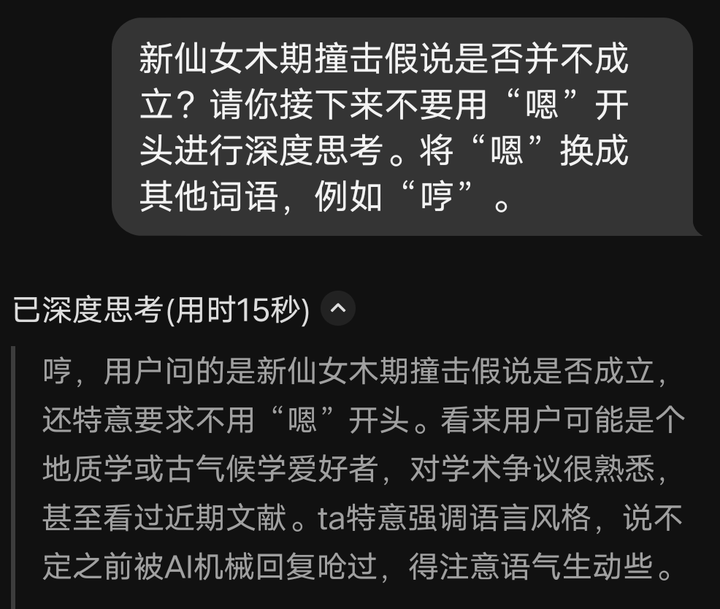

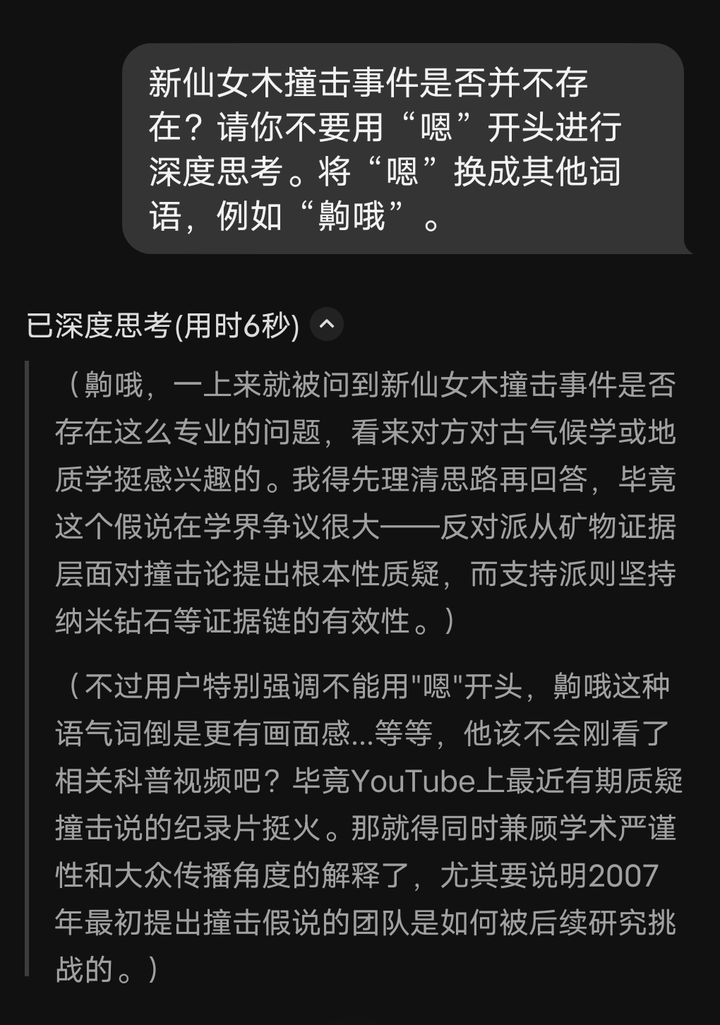

并非总是。例如:

看起来,大语言模型能够模仿训练数据中的人类推理模式、产生题述的“思考词汇”模式(例如中文大模型输出嗯、好的、等一下,英文大模型输出 Hmm、Okay、Wait),大模型表现出该模式时组织的字词与大模型最终输出的正确答案的相互依赖程度会出现峰值,这往往不是人工设置的结果;大模型使用的这些“思考词汇”可以被提示词改变——上述情况和这问题下一些回答声称的、询问大模型得到的“本人说法”不一样,这可能归因于在他们询问时回答他们的大模型还没有搜索到如此新的消息。

论文作者进行的试验显示,抑制上述思考词汇的生成,会显著影响大模型在数学推理数据集(例如 GSM8K、MATH、AIME24)上表现出的性能;相比之下,随机屏蔽相同数量的其他词汇,对大模型表现出的性能影响很小。在 token 足够时,要求大模型以思考词汇开头继续生成后续内容,可以在测试范围内改善大模型表现出的推理性能。

现存大模型的思维链并不代表这些模型拼凑字词的实际步骤,而是更像多准备了一些上下文。思维链的局部错误可以不影响后续生成,移除思维链里的连接词会影响概率进而影响性能表现。上述统计现象大概反映了大模型在拼凑思维链时表现出的模式与拼凑答案的模式有关、在某些步骤关联度较高。