全球首款 AI 多人游戏来了!你的老电脑也能玩 | 附下载地址

AI 玩游戏,不稀奇;AI 编游戏,也不新鲜。

但用 AI 构建一个支持两个人实时互动、视角一致、逻辑同步的游戏世界?这事儿,今天才第一次发生。

以色列 Enigma Labs 团队今天在 X 平台宣称发布全球首款由 AI 生成的多人游戏——Multiverse(多重宇宙)。名字听起来就像漫威出品,玩法也确实够科幻。

漂移、撞车,全都同步,操作互相响应,细节还能对上帧数。

游戏里的一切,不再靠预设剧本或物理引擎控制,而是由一个 AI 模型实时生成,确保两名玩家看到的是同一个逻辑统一的世界。

而且 Multiverse 已经全面开源:代码、模型、数据、文档一应俱全,全都放到了 GitHub 和 Hugging Face 上。你甚至能在自己电脑上直接跑起来。

Hugging Face CEO Clément Delangue 也在 X 平台在线打 call:

这是我今天在 Hugging Face 上看到的最酷的数据集:Gran Turismo 4 中 1 对 1 竞速的动作标签,用来训练一个多人世界模型

车辆在赛道上不断变换位置,超车、漂移、加速,然后再次在某个路段汇合。

那这款名为 Multiverse 的模型,究竟是怎么一回事?官方技术团队用一篇技术博客分享了更多构建细节。

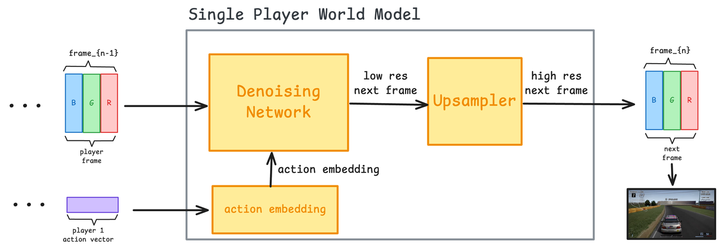

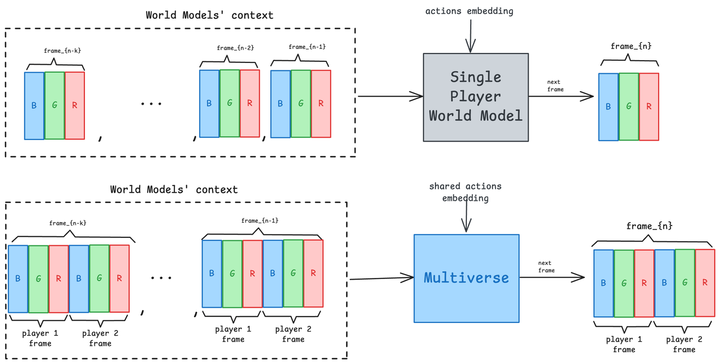

在此之前,我们得先介绍一下传统 AI 世界模型:你操作一下,它预测一下画面需要怎样生成。模型看你的操作、看前几帧,然后生成下一帧。原理嘛,说起来也不难理解:

- 动作嵌入器:把玩家操作(比如你按了哪个键)转成嵌入向量

- 去噪网络:使用扩散模型,结合操作和前几帧画面,预测下一帧

- 上采样器(可选):对生成画面进行分辨率和细节增强处理

但一旦引入第二名玩家,问题就复杂了。

最典型的 bug 是,你这边赛车刚撞上护栏,对手那边却还在风驰电掣;你甩出赛道,对方却根本没看见你在哪。整个游戏体验就像卡了两帧,还不同步。

而 Multiverse,正是第一款能同步两个玩家视角的 AI 世界模型,无论哪个玩家发生了什么,另一个人都能实时在自己画面中看到,毫无延迟、无逻辑冲突。

这也是过去 AI 模拟很难搞定的一点:多视角一致性。

要想解决这一点,构建真正的协作式多人世界模型,Multiverse 团队想到了一个很聪明的的方案。他们保留了核心组件,同时把原本的「单人预测」思路全打碎重构:

- 动作嵌入器:接收两个玩家的动作,输出一个整合了双方操作的嵌入向量;

- 去噪网络:扩散网络,同时生成两个玩家的画面,确保它们作为一个整体一致;

- 上采样器:与单人模式类似,但同时对两个玩家的画面进行处理和增强。

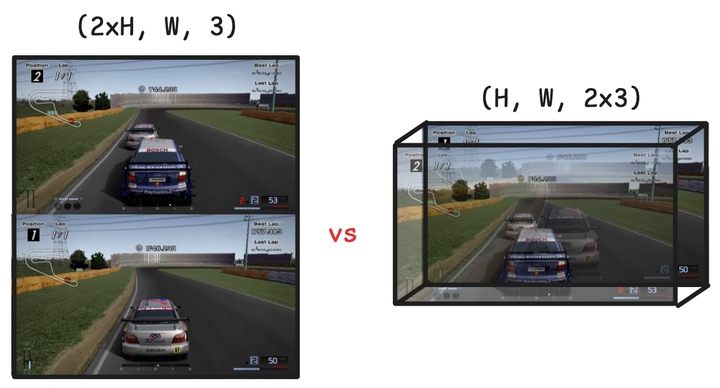

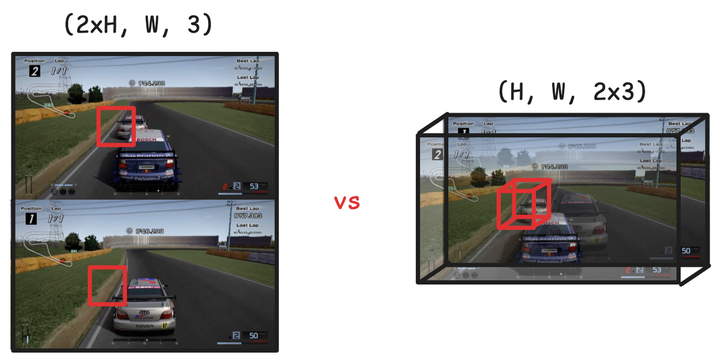

本来,处理双人画面,很多人第一反应是分屏:把两幅画分开,各自生成。

这思路简单粗暴,但同步难、资源耗、效果差,但他们想到将两个玩家的视角「缝合」成一个画面,将他们的输入合并为一个统一的动作向量,整体当作一个「统一场景」来处理。

具体做法是通道轴堆叠:把两个画面作为一张拥有双倍颜色通道的图像处理。

这事儿听着小,技术上其实非常聪明。因为扩散模型采用的是 U-Net 架构,核心是卷积和反卷积,而卷积神经网络对通道维度的结构感知能力极强。

换句话说,这不是把两个世界贴一起,而是让模型从「神经元底层」就知道这两个画面是有关联的,是要协同生成的。最终的画面,不用手动对齐,天然同步。

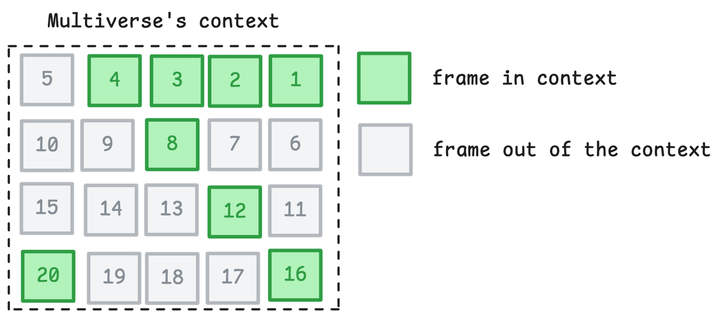

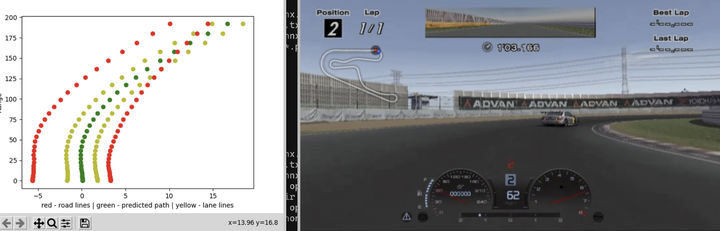

但要让模型预测下一帧准确无误,还得搞清楚一件事:车速和相对位置是动态的,预测得准,得有足够的信息。他们发现:8 帧(30 fps 条件下)足以学习加速、刹车、转向等运动学特征。

但问题在于:超车等相对速度远比绝对速度慢得多(约 100 km/h vs 5 km/h),帧数要是太近,模型根本感知不到变化。

于是他们设计了一个折中方案 —— 稀疏采样:

- 提供最近连续的 4 帧(确保即时响应);

- 再额外提供 4 帧「隔 4 帧采样」的历史画面;

- 最早一帧距离当前帧 20 帧,也就是约 0.666 秒前。

而要真正让模型理解「协同驾驶」,不能只靠这些输入数据,还得在互动行为上做强化训练。

传统单人任务(比如走路、打枪)只需要预测很短的时间窗口,比如 0.25 秒。但多人交互下,这么点时间变化微乎其微,根本体现不出「组队感」。

Multiverse 的解法是:干脆让模型预测长达 15 秒 的行为序列,以此捕捉长周期、多轮次的互动逻辑。

训练方法也不是一下就上 15 秒,而是用了一套「课程式学习(curriculum learning)」策略:从 0.25 秒预测开始,逐步延长到 15 秒。这样模型先学会汽车结构、赛道几何这些底层特征,再慢慢掌握玩家策略、博弈动态这些高阶概念。

训练完之后,模型在物体持续性、帧间一致性方面表现明显提升。简而言之,不会突然车子消失,也不会前后逻辑崩坏。

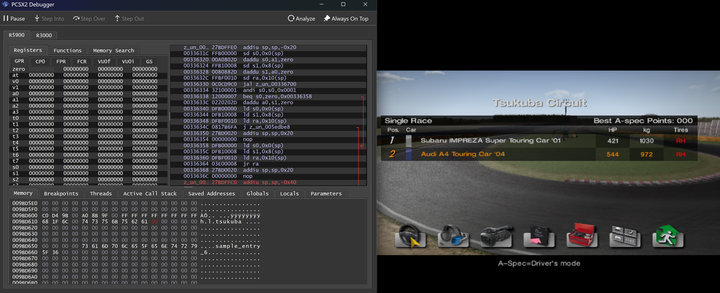

如此出色的训练表现,归功于其背后精心挑选的数据集。没错,就是那款 2004 年 PS2 上的神作赛车模拟游戏:Gran Turismo 4。

当然,为了免责,Multiverse 团队也没忘记调侃自己是索尼的铁杆粉丝。

他们的测试场景是筑波赛道上的 1 对 1 比赛,但问题是 GT4 并不原生支持「1v1 视角回放」。所以他们逆向工程了一把,硬生生把游戏改造出一个真实的 1v1 模式。

接着:

- 每场比赛录两次,一次看自己,一次看对手;

- 再通过同步处理,合并为一个完整视频,展示双方实时对战画面。

那按键数据怎么办,毕竟游戏本身没提供操作日志。

答案是,他们利用游戏 HUD 显示的信息(油门、刹车、方向盘指示条),通过计算机视觉,逐帧提取游戏屏幕上显示的油门、刹车、方向条,再反推出控制指令。

也就是说,全靠画面信息就能还原操作,无需额外日志文件。

当然,这个流程效率偏低,总不可能每场比赛都得人工录两遍。

他们发现 GT4 有个隐藏功能叫 B-Spec 模式,可以让 AI 自己开车。于是就写了个脚本,给 AI 发随机指令,让它自己开比赛、自己撞车、从而批量生成数据集。

顺便,他们还试过用 OpenPilot 的自动驾驶模型控制游戏角色,虽然效果不错,但就效率和稳定性而言,B-Spec 更适合做大规模训练。

重点来了,谈效果,不谈成本,自然是耍流氓。

这么一个能跑多视角世界、画面同步、稳定输出的 AI 模型,模型、训练、数据、推理全算上,全程只花了 1500 刀,跟买台高端显卡差不多。

Multiverse 员工 Jonathan Jacobi 在 X 上发文写道:

我们只用了 1500 美元就构建了 Multiverse,关键不在算力,而在技术创新。

更重要的是,Jacobi 认为,多人世界模型不仅是 AI 玩游戏的新方式,更是模拟技术的下一步。它解锁了一个全新的世界:由玩家、智能体和机器人共同进化、共同塑造的动态环境。

未来,世界模型可能就像是虚拟版的真实社会:你与 AI 共处其中,形成真实感极强的「动态宇宙」,同时也拥有接近现实社会的复杂互动逻辑。

所以,你说这事儿听起来是不是有点上头?

附上参考地址:

GitHub:https://github.com/EnigmaLabsAI/multiverse

Hugging Face 数据集:https://huggingface.co/datasets/Enigma-AI/multiplayer-racing-low-res

Hugging Face 模型:https://huggingface.co/Enigma-AI/multiverse

官方博客:https://enigma-labs.io/blog