端侧 AI,是存在的 | 爱范儿

2025 年最酷的硬件设备是什么?

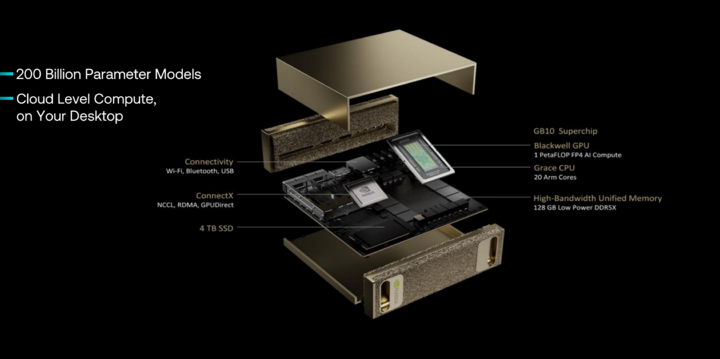

很多人可能会把答案颁发给还没有正式上市的英伟达 NVIDIA DGX Spark 个人 AI 超级计算机,这个 AI 超级计算机搭载 NVIDIA GB10 Grace Blackwell 超级芯片,整合了 Blackwell 架构 GPU 和 20 核 Arm CPU(10×Cortex-X925 + 10×Cortex-A725),支持第五代 Tensor Core 和 FP4 精度,提供高达 1000 AI TOPS 的计算性能。另外配备 128GB LPDDR5x 统一内存(带宽 273 GB/s)和可选 1TB/4TB NVMe SSD,支持本地运行多达 2000 亿参数的 AI 模型,双机互联可扩展至 4050 亿参数。

这意味着普通消费者有机会获得属于端侧的超级 AI 算力,大模型完全运行在本地,无需再进行联网。

所以,Arm 高级副总裁兼终端事业部总经理 Chris Bergey 在最近的台北电脑展 ComputeX 上的主题演讲中说:

一年前经常会被问及的一个问题是:端侧 AI 真的会实现吗?现在已经基本没有这样的疑问了,因为我们正在亲眼见证计算量的增长,以及在各个场景中部署 AI 所带来的巨大机遇。

上面提到的 NVIDIA DGX Spark 个人 AI 超级计算机所使用的 CPU 就是 Arm 架构的。

我们不妨在此看看 Chris Bergey 的演讲分享全文:

人工智能 (AI) 的发展无处不在,这正是我们所观察到的趋势。AI 将渗透到我们生活中的方方面面、渗透进众多不同行业与经济体。仅回顾过去一年中所发生的变化,其发展速度之快令人惊叹。

正因如此,AI 模型正变得更加智能。并且它们的规模也在各个方面变得更小且能力更强。这是由于所需计算量的变化以及模型本身的演进,正在真正推动端侧 AI 的发展。而且,这一趋势已经远远超出了智能手机的范畴。

一年前经常会被问及的一个问题是:端侧 AI 真的会实现吗?现在已经基本没有这样的疑问了,因为我们正在亲眼见证计算量的增长,以及在各个场景中部署 AI 所带来的巨大机遇。

此外,我们还开始看到 AI 智能体的出现,以及由实体 AI 衍生的新机遇。具体而言,在 AI 智能体方面,已经出现了一些非常有趣的应用场景和非常成功的商业项目或初创公司。其中两个颇受关注的领域是:第一,利用 AI 进行编程、代码审查和修改;第二,利用 AI 提升客户支持与客户服务。在这两个领域中,一些初创公司正迅速成长,在员工人数不到 100 人的情况下快速实现一亿美元的营收。

显然,实体 AI 也蕴藏着巨大的机会。我们已经看到机器人技术开始在多个领域得到应用,比如机器狗、配送机器人、扫地机器人等。这些设备在某种程度上已经实现了自主运行,但很难说它们已经达到了与人类操作相当的智能水平。不过,在接下来的一到三年内,我们很快就会迎来这样的转变:当这些设备处于自主模式运行时,其表现将能够媲美人类操作。这将带来巨大的发展机遇。

从构建 AI 系统的基础要素来看,我们认为有三个关键因素:首先,从云端到边缘打造一个无处不在的平台将具有极大的价值。因为很多时候 AI 是在端侧运行的,但在某些情况下,又希望能够将工作负载转移到云端。因此,拥有一个高度且可移植的平台,对于推动先进技术及产品的实现,以及为现有产品增加新功能,都是非常有价值的。

第二个关键点是电力和每瓦性能。AI 催生了巨大的机遇,但同时也极为耗电。在数据中心,我们已经看到其能耗从兆瓦级 (MW) 跃升至吉瓦 (GW) 级,而其中超过 50% 实际上来自于机架和半导体设备。因此,在 AI 赋能的世界里,虽然存在巨大的发展潜力,但也需要海量的计算能力,这意味着“每瓦性能”可能是最关键的衡量指标。

虽然为 AI 构建硬件颇具挑战性,但软件同样至关重要。Arm 目前拥有全球最大的开发者生态,汇聚了超过 2,200 万名软件开发者。与此同时,基于 Arm 架构的芯片出货量迄今已累计超过 3,100 亿颗。这种规模带来了一个良性循环:大量的基于 Arm 技术的设备推动了丰富的 Arm 软件生态,而强大的软件生态又进一步催生了更多硬件的发展机会。

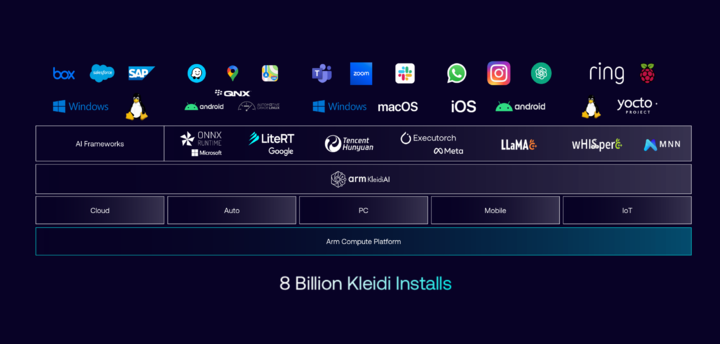

我们在去年推出了 Arm Kleidi,旨在提供一个 AI 软件库,能够让 AI 工作负载在最新的 Arm CPU——也就是 Armv9 架构上加速运行,同时也具备面向未来的可持续性。目前我们已经看到 Kleidi 在多个市场中得到了广泛应用:迄今为止,Kleidi 已累计超过 80 亿次安装,且仍在持续增长中。Kleidi 也与许多全球主流的 AI 框架进行集成,包括国内的腾讯混元的 Angel 机器学习框架。

Arm 在终端设备和边缘侧的应用已为大家所熟知。与此同时,我们也一直强调在数据中心领域布局,并已在这个领域深耕十多年之久。因此,不仅仅是边缘侧的 AI 软件运行在 Arm 架构之上,数据中心中的 AI 也将基于 Arm 架构运行。

譬如,全球最大的云服务提供商亚马逊云科技 (AWS) 去年秋季就曾分享,他们有相当一部分自身的工作负载是运行在基于 Arm 架构的 AWS Graviton 处理器上。

而这不局限于 AWS 的内部工作负载。AWS 还曾分享,其超过 90% 的重要客户(不包括 Amazon)也在使用 Arm 的先进架构,并受益于 Arm 技术的卓越能效。这些客户都是业界耳熟能详的企业。这意味着,过去两年,AWS 新部署的 CPU 算力中,有超过 50% 是基于 Arm 技术的 Graviton。

最初,云服务提供商自身的第一方工作负载迁移至 Arm 平台,随后,第三方工作负载也纷纷转向 Arm 平台,这为头部云服务提供商带来了超过 40% 的能效提升 。基于这样的发展势头,我们预计 Arm 架构将占据半数 2025 年出货到头部云服务提供商的算力。

回到边缘侧,Arm CPU 在该领域占据举足轻重的地位,被广泛应用于各种主流操作系统 (OS) 的边缘计算设备中。得益于此,近年来,Arm 架构在 PC 与平板市场的需求也大幅增长,因此我们预估,在 2025 年,Arm 架构将占据超过 40% 的 PC 与平板整体出货量。

回顾近期市场上推出的一系列平台,这些平台都是基于我们在去年此时发布的 IP 所打造的。其中有一个产品我想重点介绍一下,那就是 NVIDIA DGX Spark,它搭载了 10 个 Arm Cortex-X925 核心和 10 个 Cortex-A725 核心,并配备了可实现高达 1 PetaFLOPs(即每秒 10^15 次浮点运算) AI 性能的 GPU。这是一种将数据中心级别的计算能力带到了桌面级产品。

作为 AI 领域的领导者,NVIDIA 不仅在边缘侧通过 Arm 技术进行 AI 计算,同时也将其数据中心产品转向 Arm 架构。比如在 Grace Blackwell 等产品中,NVIDIA 将基于 Arm 架构的 CPU 与 GPU 紧密耦合,针对 AI 所需的带宽和 I/O 密度进行了深度优化,从而实现了更高效的计算性能。

在中国手机市场,Arm 正在为众多的生态合作伙伴(如 MediaTek)提供最前沿的 CPU 和 GPU 技术,并且这些合作伙伴正与众多一线手机厂商携手,将搭载 Arm 技术的优秀手机产品推向市场。

而这些获得高度认可的手机产品,均是基于我们一年前发布的计算平台打造而成,其中包括 Arm Cortex-X925。我们曾强调,Cortex-X925 具备业内最高水平的 IPC 性能。这一点至关重要,因为 IPC(每时钟周期指令数)与频率的乘积决定了整个平台的性能。相较于单纯依赖提高频率来提升性能,提升 IPC 可以更高效地实现性能的增强,同时还能显著改善能耗表现。对于移动终端设备而言,控制功耗无疑是一个关键考量因素。

虽然我们今天不是要发布新产品,但我可以提前透露的是,我们将在今年晚些时候推出新的 Armv9 旗舰 CPU(代号Travis)。届时,在目前业内 IPC 性能最高的 Arm 处理器基础上,再次实现两位数的 IPC 性能提升。

此外,这也将是第一代引入 Armv9 可伸缩矩阵扩展 (Scalable Matrix Extensions) 的处理器。该扩展功能是专门为加速 AI 工作负载而设计的,并将成为安卓生态系统中最先进的可伸缩矩阵扩展实现。

Arm 在 GPU 方面也持续进行大量投入,并迅速被中国生态系统视为手机高性能 GPU 的领先提供商。今年我们还在此基础上加入了 Arm 精锐超级分辨率技术 (ASR),使用户能够在移动设备上实现游戏主机级画质和游戏体验。

从云端到边缘,Arm 正在处于一个非常令人振奋的发展时期。Arm 的生态系统合作伙伴亦是如此。尤其是那些基于 Arm 架构、将最先进产品推向市场的中国合作伙伴,他们正迎来一个激动人心的新时代。

我们相信 AI 的未来前景广阔,而这个未来将由 Arm 及其合作伙伴共同打造,包括我们在中国市场的重要合作伙伴。

这一段演讲我们可以划一下重点,除了讲 AI 发展趋势和机遇,Arm 的技术布局与市场前景之外,最重要的三个信息是这个:

一,云端与边缘的统一平台。由于 AI 工作负载需在端侧实时响应与云端弹性算力之间灵活切换,构建无缝衔接的统一架构成为加速技术落地的关键。例如,Arm 生态通过兼容性设计支持从手机到数据中心的跨场景部署。

二,每瓦性能的极致追求。AI 的算力需求推动数据中心能耗从兆瓦级跃升至吉瓦级,其中超 50% 能耗来自硬件本身。因此,「每瓦性能」成为衡量技术竞争力的核心指标,直接影响硬件设计、运营成本和可持续发展能力。

三,软件生态的良性循环。以 Arm 为例,其全球最大的开发者社区(2200 万人)与累计 3100 亿颗芯片出货量形成正向反馈——庞大的硬件基数吸引更多软件适配,而丰富的软件生态又进一步推动硬件创新。Arm 推出的 Kleidi AI 软件库已集成腾讯混元等主流框架,安装量超 80 亿次,成为端侧 AI 加速的重要工具。

而在演讲之后的媒体问答中,Chris Bergey 也聊到了一些关于端侧 AI 的重点:

AI 能力的确将持续提升。这对 Arm 而言意味着更大的机遇。当前的很多讨论都集中在模型的构建和训练上。但现实情况是,在构建好模型之后,推理才是实现 AI 商业价值的唯一方式。因为正是推理赋予了 AI 智能性,包括让机器人做出正确决策,让手机比预想得更智能。事实上,训练当今世界上最大规模模型所需的计算量,大约是推理所需的10 的 11 次方倍。举例来说,全球每天的网页搜索次数大约是 10 的 10 次方。也就是说,需要把全球十天内的所有搜索量加起来,才能抵得上训练一个这样的模型所需的计算量。由此可以想象,我们需要运行多少推理,才能让投入训练的计算资源实现商业回报。

用个形象的比喻就是,训练模型就好像生产一台强大的货车,如果不让货车开上高速公里承担物流送货工作,那么货车就像摆设,而「推理」就像让货车上路承担实际的送货任务,每一次送货都需要燃料来驱动引擎,这里面的工作就像芯片提供算力一样。

当然,在 AI 计算中,GPU 和 NPU 总是被最新提到的运算单元,而 CPU 似乎提及较少,对此,Chris Bergey 也有话说:

我们通常以异构计算的角度去思考边缘 AI 计算,这包括 CPU、GPU 和 NPU 之间的协同运作。目前 NPU 较受关注,主要因为它是新兴技术,并且在每瓦特算力方面具有显著优势。但与此同时,NPU 在软件开发生态和灵活性方面也面临不小的挑战。我们实际观察到,开发者在进行 AI 开发时,会根据具体需求来决定是在 CPU、GPU 还是 NPU 上运行。大多数第三方应用实际上都是在 CPU 上进行 AI 开发的,其中有 70% 会始终运行在 CPU 上,而不会迁移到 GPU 或 NPU,当然也有不少应用借助 GPU 进行加速。

这一切都在不断演进中,我们坚信异构计算是未来的发展方向,因为 AI 工作负载本身也在持续变化。我们之前也谈到过对 AI 的预期,实现这些预期需要多种计算单元的协同。因此我们才会在 CPU 和 GPU 的研发上投入如此之多,确保它们在 AI 任务中具备强大的性能,包括在软件层面 Kleidi 上的投入,以及现在在可伸缩矩阵扩展 (SME) 方面的推进。

他还提到:

因为 AI 的发展速度非常快,从开始设计到产品上市往往需要一到两年时间,而这期间 AI 模型可能已经发生了巨大变化。正因如此,CPU 和 GPU 有时反而能优于一些专用硬件加速器,因为它们在应对变化需求方面更具灵活性。所以,(端侧 AI 的落地)核心要素在于内存、内存带宽,以及设计上的灵活性。

至此,我们也就大概理解了 Arm 眼里的端侧 AI 愿景:端侧 AI 的崛起成为显著趋势——得益于模型优化和算力需求的平衡,AI 不再局限于云端或智能手机,而是扩展至机器人(如配送机器狗、扫地机器人)、工业设备、PC 等多元场景。未来 1-3 年内,实体 AI 的自主性有望达到接近人类操作的水平,这将为物流、服务和制造业带来颠覆性机会。