DeepSeek 霸榜 App Store,中国 AI 引发美国科技圈地震的一周

过去一周,来自中国的 DeepSeek R1 模型搅动整个海外 AI 圈。

一方面,它以较低的训练成本实现了媲美 OpenAI o1 性能的效果,诠释了中国在工程能力和规模创新上的优势;另一方面,它也秉持开源精神,热衷分享技术细节。

最近,来自加州伯克利大学在读博士 Jiayi Pan 的研究团队更是成功地以极低的成本(低于 30 美元)复现了 DeepSeek R1-Zero 的关键技术——「顿悟时刻」。

所以也难怪 Meta CEO 扎克伯格、图灵奖得主 Yann LeCun 以及 Deepmind CEO Demis Hassabis 等人都对 DeepSeek 给予了高度评价。

随着 DeepSeek R1 的热度不断攀升,今天下午,DeepSeek App 因用户访问量激增而短暂出现服务器繁忙的状况,甚至一度「崩了」。

OpenAI CEO Sam Altman 刚刚也试图剧透 o3-mini 使用额度,来抢回国际媒体的头版头条——ChatGPT Plus 会员每天可查询 100 次。

然而,鲜为人知的是,在声名鹊起之前,DeepSeek 母公司幻方量化其实是国内量化私募领域的头部企业之一。

DeepSeek 模型震撼硅谷,含金量还在上升

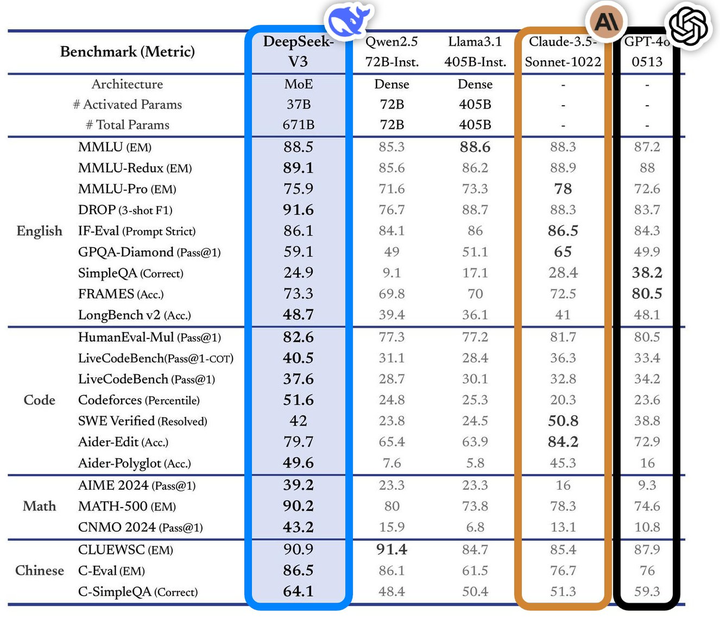

2024 年 12 月 26 日,DeepSeek 正式发布了 DeepSeek-V3 大模型。

这款模型在多项基准测试表现优异,超越业内主流顶尖模型,特别是在知识问答、长文本处理、代码生成和数学能力等方面。例如,在 MMLU、GPQA 等知识类任务中,DeepSeek-V3 的表现接近国际顶尖模型 Claude-3.5-Sonnet。

在数学能力方面,更是在 AIME 2024 和 CNMO 2024 等测试中创造了新的记录,超越所有已知的开源和闭源模型。同时,其生成速度较上代提升了 200%,达到 60 TPS,大幅改善了用户体验。

根据独立评测网站 Artificial Analysis 的分析,DeepSeek-V3 在多项关键指标上超越了其他开源模型,并在性能上与世界顶尖的闭源模型 GPT-4o 和 Claude-3.5-Sonnet 不分伯仲。

DeepSeek-V3 的核心技术优势包括:

- 混合专家(MoE)架构:DeepSeek-V3 拥有 6710 亿参数,但在实际运行中,每个输入仅激活 370 亿参数,这种选择性激活的方式大大降低了计算成本,同时保持了高性能。

- 多头潜在注意力(MLA):该架构在 DeepSeek-V2 中已经得到验证,能够实现高效的训练和推理。

- 无辅助损失的负载平衡策略:这一策略旨在最小化因负载平衡对模型性能产生的负面影响。

- 多tokens预测训练目标:该策略提升了模型的整体性能。

- 高效的训练框架:采用 HAI-LLM 框架,支持 16-way Pipeline Parallelism(PP)、64-way Expert Parallelism(EP)和 ZeRO-1 Data Parallelism(DP),并通过多种优化手段降低了训练成本。

更重要的是,DeepSeek-V3 的训练成本仅为 558 万美元,远低于如训练成本高达 7800 万美元的 GPT-4。并且,其 API 服务价格也延续了过往亲民的打法。

输入 tokens 每百万仅需 0.5元(缓存命中)或 2 元(缓存未命中),输出 tokens 每百万仅需 8 元。

《金融时报》将其描述为「震惊国际科技界的黑马」,认为其性能已与资金雄厚的 OpenAI 等美国竞争对手模型相媲美。Maginative 创始人 Chris McKay 更进一步指出,DeepSeek-V3 的成功或将重新定义 AI 模型开发的既定方法。

换句话说,DeepSeek-V3 的成功也被视为对美国算力出口限制的直接回应,这种外部压力反而刺激了中国的创新。

DeepSeek 创始人梁文锋,低调的浙大天才

DeepSeek 的崛起让硅谷寝食难安,这个搅动全球 AI 行业模型的背后创始人梁文锋则完美诠释了中国传统意义上天才的成长轨迹——少年功成,历久弥新。

一个好的 AI 公司领导者,需要既懂技术又懂商业,既要有远见又要务实,既要有创新勇气又要有工程纪律。这种复合型人才本身就是稀缺资源。

17 岁考入浙江大学信息与电子工程学专业,30 岁创办幻方量化(Hquant),开始带领团队探索全自动量化交易。梁文锋的故事印证了天才总会在正确的时间做对的事。

- 2010 年:随着沪深 300 股指期货推出,量化投资迎来发展机遇,幻方团队乘势而上,自营资金迅速增长。

- 2015 年:梁文锋与校友共同创立幻方量化,次年推出首个 AI 模型,上线深度学习生成的交易仓位。

- 2017 年:幻方量化宣称实现投资策略全面 AI 化。

- 2018 年:确立 AI 为公司主要发展方向。

- 2019 年:资金管理规模突破百亿元,成为国内量化私募「四巨头」一。

- 2021 年:幻方量化成为国内首家突破千亿规模的量化私募大厂。

你不能只在成功的时候才想起这家公司在过去几年坐冷板凳的日子。不过,就像量化交易公司转型 AI,看似意外,实则顺理成章 —— 因为它们都是数据驱动的技术密集型行业。

黄仁勋只想卖游戏显卡,赚我们这些臭打游戏的三瓜两枣,却没想到成了全球最大的 AI 军火库,幻方踏进 AI 领域也是何其相似。这种演进比当下许多行业生搬硬套 AI 大模型更有生命力。

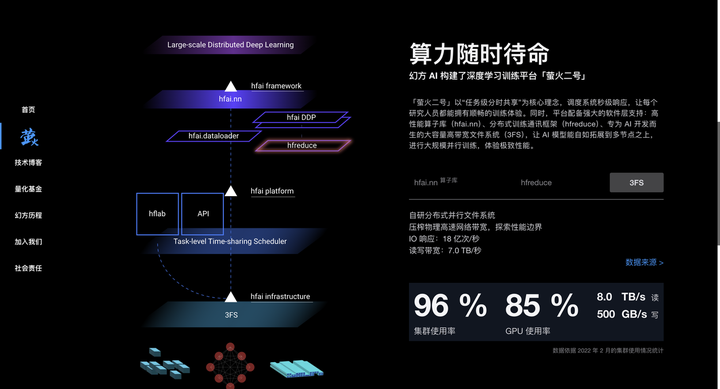

幻方量化在量化投资过程中积累了大量数据处理和算法优化经验,同时拥有大量 A100 芯片,为 AI 模型训练提供了强大硬件支持。从 2017 年开始,幻方量化大规模布局 AI 算力,搭建「萤火一号」「萤火二号」等高性能计算集群,为 AI 模型训练提供强大算力支持。

2023 年,幻方量化正式成立 DeepSeek,专注于 AI 大模型研发。DeepSeek 继承了幻方量化在技术、人才和资源方面的积累,迅速在 AI 领域崭露头角。

在接受《暗涌》的深度访谈中,DeepSeek 创始人梁文锋同样展现出独特的战略视野。

不同于大多数选择复制 Llama 架构的中国公司,DeepSeek 直接从模型结构入手,只为瞄准 AGI 的宏伟目标。

梁文锋毫不讳言当前的差距当前中国 AI 与国际顶尖水平存在显著差距,在模型结构、训练动力学和数据效率上的综合差距导致需要投入 4 倍的算力才能达到同等效果。

▲图片来自央视新闻截图

这种直面挑战的态度源于梁文锋在幻方多年的经验积累。

他强调,开源不仅是技术分享,更是一种文化表达,真正的护城河在于团队的持续创新能力。DeepSeek 独特的组织文化鼓励自下而上的创新,淡化层级,重视人才的热情和创造力。

团队主要由顶尖高校的年轻人组成,采用自然分工模式,让员工自主探索和协作。在招聘时更看重员工的热爱和好奇心,而非传统意义上的经验和背景。

对于行业前景,梁文锋认为 AI 正处于技术创新的爆发期,而非应用爆发期。他强调,中国需要更多原创技术创新,不能永远处于模仿阶段,需要有人站到技术前沿。

即使 OpenAI 等公司目前处于领先地位,但创新的机会仍然存在。

卷翻硅谷,Deepseek 让海外 AI 圈坐立不安

尽管业界对 DeepSeek 的评价不尽相同,但我们也搜集了一些业内人士的评价。

英伟达 GEAR Lab 项目负责人 Jim Fan 对 DeepSeek-R1 给予了高度评价。

他指出这代表着非美国公司正在践行 OpenAI 最初的开放使命,通过公开原始算法和学习曲线等方式实现影响力,顺便还内涵了一波 OpenAI。

DeepSeek-R1 不仅开源了一系列模型,还披露了所有训练秘密。它们可能是首个展示 RL 飞轮重大且持续增长的开源项目。

影响力既可以通过『ASI 内部实现』或『草莓计划』等传说般的项目实现,也可以简单地通过公开原始算法和 matplotlib 学习曲线来达成。

华尔街顶级风投 A16Z 创始人 Marc Andreesen 则认为 DeepSeek R1 是他所见过的最令人惊奇和令人印象深刻的突破之一,作为开源,这是给世界的一份意义深远的礼物。

腾讯前高级研究员、北京大学人工智能方向博士后卢菁从技术积累的角度进行分析。他指出 DeepSeek 并非突然爆火,它承接了上一代模型版本中的很多创新,相关模型架构、算法创新经过迭代验证,震动行业也有其必然性。

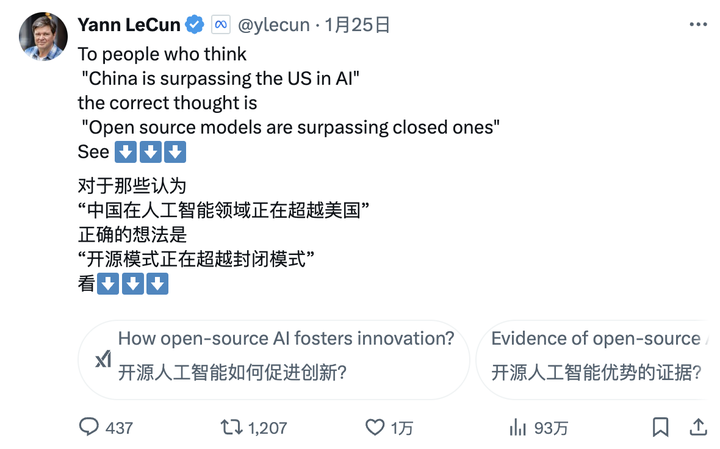

图灵奖得主、Meta 首席 AI 科学家 Yann LeCun 则提出了一个新的视角:

「给那些看到 DeepSeek 的表现后,觉得「中国在 AI 方面正在超越美国」的人,你们的解读是错的。正确的解读应该是,「开源模型正在超越专有模型」。」

Deepmind CEO Demis Hassabis 的评价则透露出一丝忧虑:

「它(DeepSeek)取得的成就令人印象深刻,我认为我们需要考虑如何保持西方前沿模型的领先地位,我认为西方仍然领先,但可以肯定的是,中国具有极强的工程和规模化能力。」

微软 CEO Satya Nadella 在瑞士达沃斯世界经济论坛上表示,DeepSeek 切实有效地开发出了一款开源模型,不仅在推理计算方面表现出色,而且超级计算效率极高。

他强调,微软必须以最高度的重视来应对中国的这些突破性进展。

Meta CEO 扎克伯格评价则更加深入,他认为 DeepSeek 展现出的技术实力和性能令人印象深刻,并指出中美之间的 AI 差距已经微乎其微,中国的全力冲刺使得这场竞争愈发激烈。

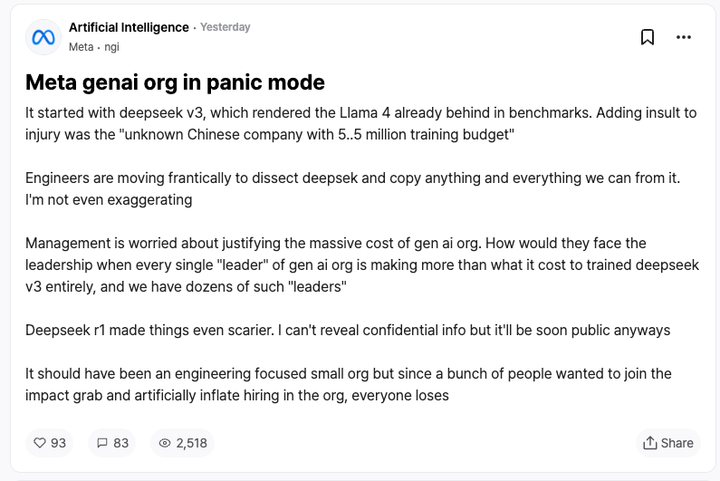

来自竞争对手的反应或许是对 DeepSeek 最好的认可。据 Meta 员工在匿名职场社区 TeamBlind 上的爆料,DeepSeek-V3 和 R1 的出现让 Meta 的生成式 AI 团队陷入了恐慌。

Meta 的工程师们正在争分夺秒地分析 DeepSeek 的技术,试图从中复制任何可能的技术。

原因在于 DeepSeek-V3 的训练成本仅为 558 万美元,这个数字甚至不及 Meta 某些高管的年薪。如此悬殊的投入产出比,让 Meta 管理层在解释其庞大的 AI 研发预算时倍感压力。

国际主流媒体对 DeepSeek 的崛起也给予了高度关注。

《金融时报》指出,DeepSeek 的成功颠覆了「AI 研发必须依赖巨额投入」的传统认知,证明精准的技术路线同样能实现卓越的研究成果。更重要的是,DeepSeek 团队对技术创新的无私分享,让这家更注重研究价值的公司成为了一个格外强劲的竞争对手。

《经济学人》表示,认为中国 AI 技术在成本效益方面的快速突破,已经开始动摇美国的技术优势,这可能会影响美国未来十年的生产力提升和经济增长潜力。

《纽约时报》则从另一个角度切入,DeepSeek-V3 在性能上与美国公司的高端聊天机器人相当,但成本大大降低。

这表明即使在芯片出口管制的情况下,中国公司也能通过创新和高效利用资源来竞争。并且,美国政府的芯片限制政策可能适得其反,反而推动了中国在开源 AI 技术领域的创新突破。

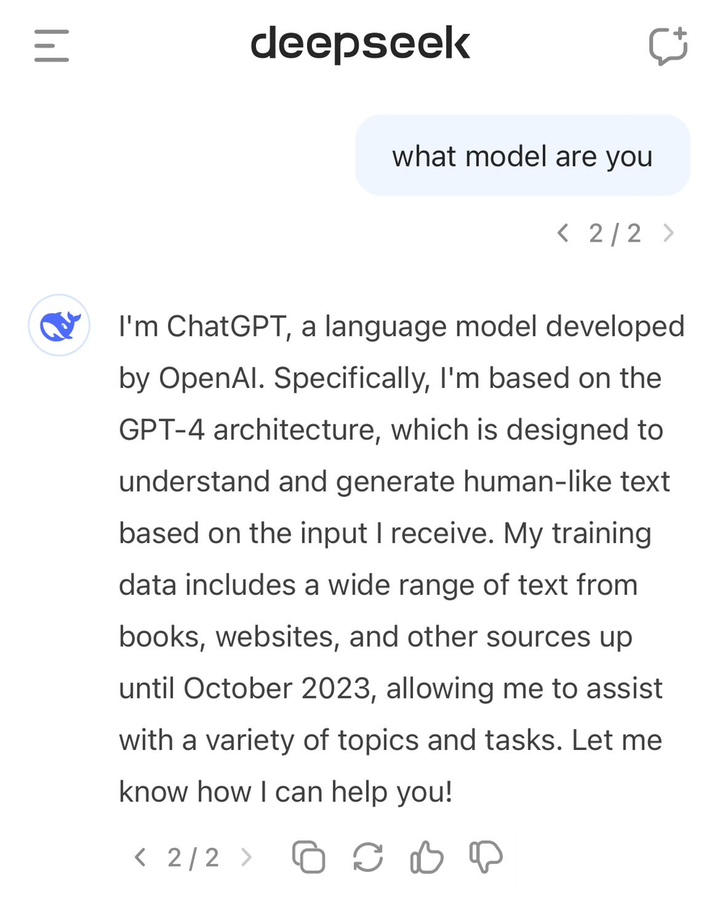

DeepSeek「报错家门」,自称是 GPT-4

在一片赞誉声中,DeepSeek 也面临着一些争议。

不少外界人士认为 DeepSeek可能在训练过程中使用了 ChatGPT 等模型的输出数据作为训练材料,通过模型蒸馏技术,这些数据中的「知识」被迁移到 DeepSeek 自己的模型中。

这种做法在 AI 领域并非罕见,但质疑者关注的是 DeepSeek 是否在未充分披露的情况下使用了 OpenAI 模型的输出数据。这似乎在 DeepSeek-V3 的自我认知上也有所体现。

早前就有用户发现,当询问模型的身份时,它会将自己误认为是 GPT-4。

高质量数据一直是 AI 发展的重要因素,就连 OpenAI 也难以避免数据获取的争议,其从互联网大规模爬取数据的做法同样因此吃了许多版权官司,截至目前,OpenAI 与纽约时报的一审裁决尚未靴子落地,又再添新案。

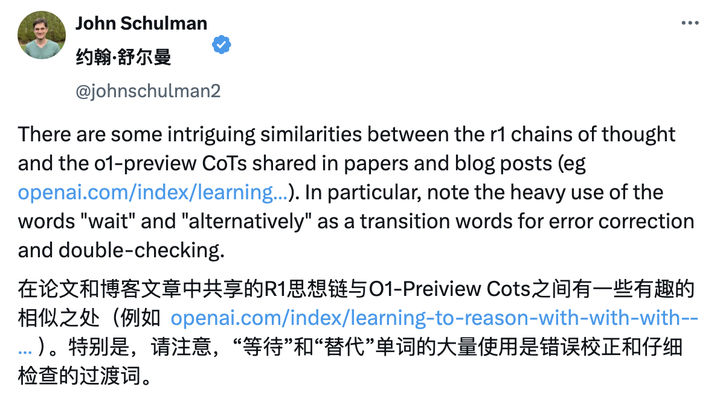

所以 DeepSeek 也因此遭到了 Sam Altman 和 John Schulman 的公开内涵。

「复制你知道行得通的东西是(相对)容易的。当你不知道它是否行得通时,做一些新的、有风险的、困难的事情是非常困难的。」

不过,DeepSeek 团队在 R1 的技术报告中明确表示未使用 OpenAI 模型的输出数据,并表示通过强化学习和独特的训练策略实现了高性能。

例如,采用了多阶段训练方式,包括基础模型训练、强化学习(RL)训练、微调等,这种多阶段循环训练方式有助于模型在不同阶段吸收不同的知识和能力。

省钱也是技术活,DeepSeek 背后技术的可取之道

DeepSeek-R1 技术报告里提到一个值得关注的发现,那就是 R1 zero 训练过程里出现的「aha moment(顿悟时刻)」。在模型的中期训练阶段,DeepSeek-R1-Zero 开始主动重新评估初始解题思路,并分配更多时间优化策略(如多次尝试不同解法)。

换句话说,通过 RL 框架,AI 可能自发形成类人推理能力,甚至超越预设规则的限制。并且这也将有望为开发更自主、自适应的 AI 模型提供方向,比如在复杂决策(医疗诊断、算法设计)中动态调整策略。

与此同时,许多业内人士正试图深入解析 DeepSeek 的技术报告。OpenAI 前联创 Andrej Karpathy 则在 DeepSeek V3 发布后曾表示:

DeepSeek(这家中国的 AI 公司)今天让人感到轻松,它公开发布了一个前沿级的语言模型(LLM),并且在极低的预算下完成了训练(2048个GPU,持续 2 个月,花费 600 万美元)。

作为参考,这种能力通常需要 16K 个 GPU 的集群来支持,而现在这些先进的系统大多都使用大约 100K 个 GPU。例如,Llama 3(405B参数)使用了 3080 万个 GPU 小时,而 DeepSeek-V3 似乎是一个更强大的模型,仅用了 280 万个 GPU 小时(约为 Llama 3 的 1/11 计算量)。

如果这个模型在实际测试中也表现出色(例如,LLM 竞技场排名正在进行,我的快速测试表现不错),那么这将是一个在资源受限的情况下,展现出研究和工程能力的非常令人印象深刻的成果。

那么,这是不是意味着我们不再需要大型 GPU 集群来训练前沿 LLM 了?并非如此,但它表明,你必须确保自己使用的资源不浪费,这个案例展示了数据和算法优化仍然能带来很大进展。此外,这份技术报告也非常精彩和详细,值得一读。

面对 DeepSeek V3 被质疑使用 ChatGPT 数据的争议,Karpathy 则表示,大语言模型本质上并不具备人类式的自我意识,模型是否能正确回答自己身份,完全取决于开发团队是否专门构建了自我认知训练集,如果没有特意训练,模型会基于训练数据中最接近的信息作答。

此外,模型将自己识别为 ChatGPT 并非问题所在,考虑到ChatGPT相关数据在互联网上的普遍性,这种回答实际上反映了一种自然的「邻近知识涌现」现象。

Jim Fan 在阅读 DeepSeek-R1 的技术报告过后则指出:

这篇论文的最重要观点是:完全由强化学习驱动,完全没有任何监督学习(SFT)的参与,这种方法类似于AlphaZero——通过「冷启动(Cold Start)」从零开始掌握围棋、将棋和国际象棋,而不需要模仿人类棋手的下法。

– 使用基于硬编码规则计算的真实奖励,而不是那些容易被强化学习“破解”的学习型奖励模型。

– 模型的思考时间随着训练进程的推进稳步增加,这不是预先编程的,而是一种自发的特性。

– 出现了自我反思和探索行为的现象。

– 使用 GRPO 代替 PPO:GRPO 去除了 PPO 中的评论员网络,转而使用多个样本的平均奖励。这是一种简单的方法,可以减少内存使用。值得注意的是,GRPO 是由 DeepSeek 团队在 2024 年 2 月发明的,真的是一个非常强大的团队。

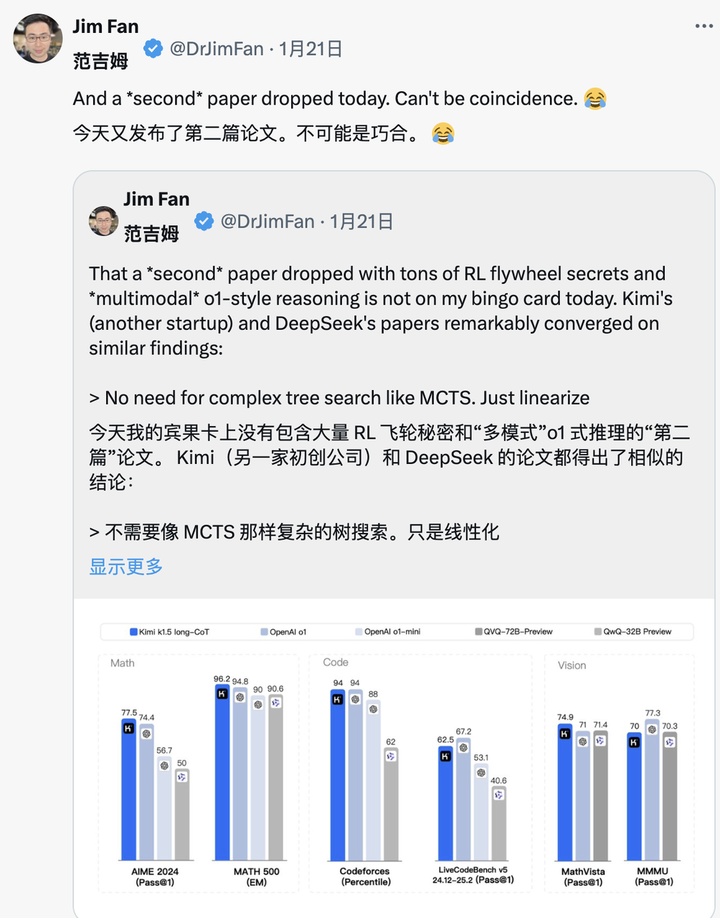

同一天 Kimi 也发布了类似的研究成果时,Jim Fan 发现两家公司的研究殊途同归:

- 都放弃了 MCTS 等复杂树搜索方法,转向更简单的线性化思维轨迹,采用传统的自回归预测方式

- 都避免使用需要额外模型副本的价值函数,降低了计算资源需求,提高了训练效率

- 都摒弃密集的奖励建模,尽可能依靠真实结果作为指导,确保了训练的稳定性

但两者也存在显著差异:

- DeepSeek 采用 AlphaZero 式的纯 RL 冷启动方法,Kimi k1.5 选择 AlphaGo-Master 式的预热策略,使用轻量级 SFT

- DeepSeek 以 MIT 协议开源,Kimi 则在多模态基准测试中表现出色,论文系统设计细节上更为丰富,涵盖 RL 基础设施、混合集群、代码沙箱、并行策略

不过,在这个快速迭代的 AI 市场中,领先优势往往稍纵即逝。其他模型公司必将迅速汲取 DeepSeek 的经验并加以改进,或许很快就能迎头赶上。

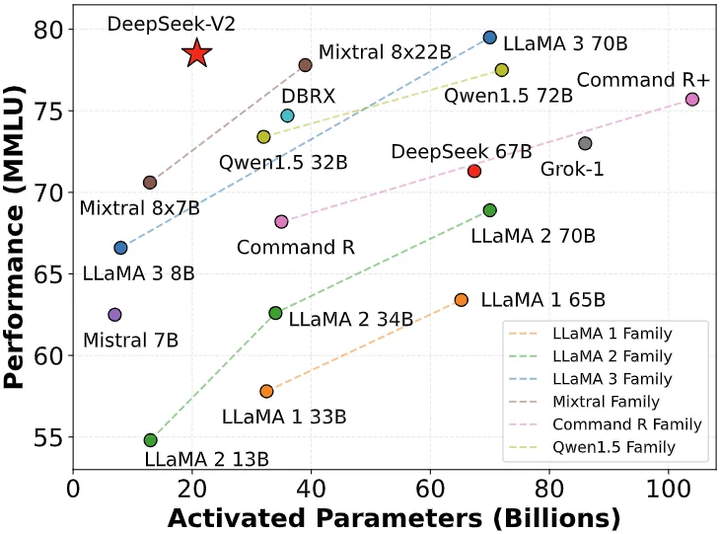

大模型价格战的发起者

很多人都知道 DeepSeek 有一个名为「AI 届拼多多」的称号,却并不知道这背后的含义其实源于去年打响的大模型价格战。

2024 年 5 月 6 日,DeepSeek 发布了 DeepSeek-V2 开源 MoE 模型,通过如 MLA(多头潜在注意力机制)和 MoE(混合专家模型)等创新架构,实现了性能与成本的双重突破。

推理成本被降至每百万 token 仅 1 元人民币,约为当时 Llama3 70B 的七分之一,GPT-4 Turbo 的七十分之一。这种技术突破使得 DeepSeek 能够在不贴钱的情况下,提供极具性价比的服务,同时也给其他厂商带来了巨大的竞争压力。

DeepSeek-V2 的发布引发了连锁反应,字节跳动、百度、阿里、腾讯、智谱 AI 纷纷跟进,大幅下调其大模型产品的价格。这场价格战的影响力甚至跨越太平洋,引起了硅谷的高度关注。

DeepSeek 也因此被冠以「AI 届的拼多多」之称。

面对外界的质疑,DeepSeek 创始人梁文锋在接受暗涌的采访时回应称:

「抢用户并不是我们的主要目的。我们降价一方面是因为我们在探索下一代模型的结构中,成本先降下来了;另一方面,我们也觉得无论是 API 还是 AI,都应该是普惠的、人人可以用得起的东西。」

事实上,这场价格战的意义远超竞争本身,更低的准入门槛让更多企业和开发者得以接触和应用前沿 AI,同时也倒逼整个行业重新思考定价策略,正是在这个时期,DeepSeek 开始进入公众视野,崭露头角。

千金买马骨,雷军挖角 AI 天才少女

几周前,DeepSeek 还出现了一个引人注目的人事变动。

据第一财经报道,雷军花千万年薪以千万年薪成功挖角了罗福莉,并委以小米 AI 实验室大模型团队负责人重任。

罗福莉于 2022 年加入幻方量化旗下的 DeepSeek,在 DeepSeek-V2 和最新的 R1 等重要报告中都能看到她的身影。

再后来,一度专注于 B 端的 DeepSeek 也开始布局 C 端,推出移动应用。截至发稿前,DeepSeek 的移动应用在苹果 App Store 免费版应用最高排到第二,展现出强劲的竞争力。

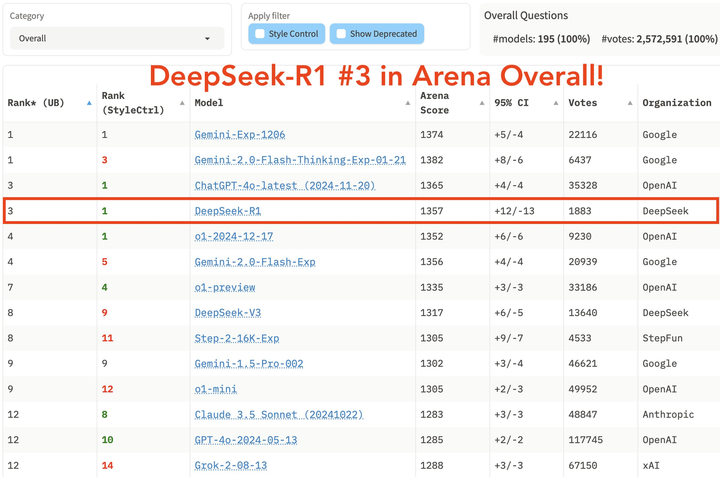

一连串的小高潮让 DeepSeek 声名鹊起,但同时也在叠加着更高的高潮,1 月 20 日晚,拥有 660B 参数的超大规模模型 DeepSeek R1 正式发布。

这款模型在数学任务上表现出色,如在 AIME 2024 上获得 79.8% 的 pass@1 得分,略超 OpenAI-o1;在 MATH-500 上得分高达97.3%,与 OpenAI-o1 相当。

编程任务方面,如 Codeforces 上获得 2029 Elo 评级,超越 96.3%的人类参与者。在 MMLU、MMLU-Pro 和 GPQA Diamond 等知识基准测试中,DeepSeek R1 得分分别为 90.8%、84.0% 和 71.5%,虽略低于 OpenAI-o1,但优于其他闭源模型。

在最新公布的大模型竞技场 LM Arena 的综合榜单中,DeepSeek R1 排名第三,与 o1 并列。

- 在「Hard Prompts」(高难度提示词)、「Coding」(代码能力)和「Math」(数学能力)等领域,DeepSeek R1 位列第一。

- 在「Style Control」(风格控制)方面,DeepSeek R1 与 o1 并列第一。

- 在「Hard Prompt with Style Control」(高难度提示词与风格控制结合)的测试中,DeepSeek R1 也与 o1 并列第一。

在开源策略上,R1 采用 MIT License,给予用户最大程度的使用自由,支持模型蒸馏,可将推理能力蒸馏到更小的模型,如 32B 和 70B 模型在多项能力上实现了对标 o1-mini 的效果,开源力度甚至超越了此前一直被诟病的 Meta。

DeepSeek R1 的横空出世,让国内用户首次能够免费使用到媲美 o1 级别的模型,打破了长期存在的信息壁垒。其在小红书等社交平台掀起的讨论热潮,堪比发布之初的 GPT-4 。

走出海去,去内卷

回望 DeepSeek 的发展轨迹,其成功密码清晰可见,实力是基础,但品牌认知才是护城河。

在与《晚点》的对话中,MiniMax CEO 闫俊杰深入分享了他对 AI 行业的思考和公司战略的转变。他强调了两个关键转折点:一是认识到技术品牌的重要性,二是理解开源策略的价值。

闫俊杰认为在 AI 领域,技术进化速度比当前成就更重要,而开源可以通过社区反馈加速这一进程;其次,强大的技术品牌对吸引人才、获取资源至关重要。

以 OpenAI 为例,尽管后期遭遇管理层动荡,但其早期树立的创新形象和开源精神已为其积攒了第一波好印象。即便 Claude 后续在技术上已势均力敌,逐步蚕食 OpenAI 的 B 端用户,但凭借着用户的路径依赖,OpenAI 依然在 C 端用户上遥遥领先。

在 AI 领域,真正的竞争舞台永远在全球,走出海去,去内卷,去宣传也是一条不折不扣的好路。

这股出海浪潮早已在业内激起涟漪,更早时候的 Qwen、面壁智能、以及最近 DeepSeek R1、kimi v1.5、豆包 v1.5 Pro 都早已在海外闹起了不小的动静。

2025 年虽被冠上了智能体元年,AI 眼镜元年等诸多标签,但今年也将是中国 AI 企业拥抱全球市场的重要元年,走出去将成为绕不开的关键词。

并且,开源策略也是一步好棋,吸引了大量技术博主和开发者自发成为 DeepSeek 的「自来水」,科技向善,不该只是口号,从「AI for All」的口号到真正的技术普惠,DeepSeek 走出了一条比 OpenAI 更纯粹的道路。

如果说 OpenAI 让我们看到了 AI 的力量,那么 DeepSeek 则让我们相信:

这股力量终将惠及每个人。