刚刚,OpenAI 最强推理模型 o3 发布!首次能用图片思考,奥特曼:天才水平 | 附实测细节

「o3 达到或接近天才的水平。」

就在刚刚,OpenAI o3/o4 mini 模型终于正式推出。直播用时接近 30 分钟,节奏快到飞起,信息量却满满当当。

o3 的发布历程本身也极具反转,今年 2 月,OpenAI 曾宣布搁置 o3 的独立发布计划,技术会打包塞进 GPT-5 里。到了 4 月初,深谙「饥饿营销」 的 Altman 却宣称计划有变:

o3 要先上,GPT-5 反而得等等,最快也得几个月后。

划重点,OpenAI o3/o4 mini 亮点如下:

- o 系列迄今最智能的模型,推理能力大幅提升,思考时间越长,效果越好。

- 首次将图像直接融入思维链,用图片「思考」,能直接调用工具处理图片。

- 首次全面支持网页搜索、文件分析、Python 代码执行、视觉输入深度推理和图像生成等功能。

- 成本效率上优于前代,o3 在相同延迟和成本下性能更强。

在模型选择器上取代 o1 等模型,ChatGPT Plus、Pro 和 Team 用户即日起可使用 o3、o4-mini 和 o4-mini-high,企业与教育用户一周后获访问权限。o3-pro 预计数周内发布。

免费用户可通过「Think」模式使用 o4-mini,速率限制不变。

开发者则通过 Chat Completions API 和 Responses API 访问,支持推理摘要和函数调用优化,即将支持网页搜索等内置工具。

OpenAI 最强推理模型 o3 发布,GPT-5 还会远吗?

最新发布的 o3 和 o4-mini,是 o 系列迄今最智能的模型。

这两款模型在推理能力、工具使用和多模态处理上表现出色,能够更长时间思考复杂问题,首次全面支持网页搜索、文件分析、Python 代码执行、视觉输入深度推理和图像生成。

上至高级研究人员,下至普通用户,新模型适用的场景也更广泛。

OpenAI o3 和 o4-mini 可以调用 ChatGPT 中的工具,并通过 API 中的函数调用访问自定义工具。

OpenAI Releases o3 and o4-mini, Says o3 Can ‘Generate Novel Hypotheses’ | Beebom

通过强化学习,OpenAI 还训练了这两个模型如何使用工具 ——不仅知道如何用、何时用,还能以正确格式快速生成可靠答案,通常耗时不到一分钟。

比如,当被问及加州夏季的能源使用量与去年相比如何时,能上网查询公共能源消耗数据,写 Python 代码预测,生成图表或图片,并解释预测依据,流畅串联多种工具。

整个推理搜索过程也胜在灵活多变:模型可多次调用搜索引擎,交叉验证结果;若自有知识不足,还能进一步挖掘信息、整合跨类型输出。

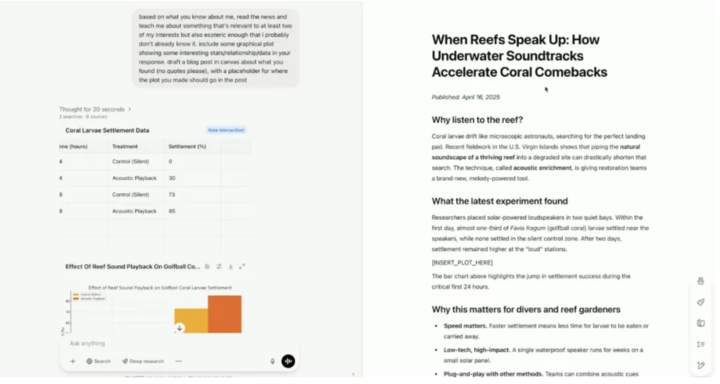

在今天凌晨的直播环节,OpenAI 总裁 Greg Brockman 也罕见露面。OpenAI 演示者则展示了新模型如何结合用户兴趣,发现用户可能感兴趣但尚未知道的内容。

新模型启用「记忆」功能后,能够了解演示者的兴趣爱好——跳伞和音乐。

不是简单分别讨论两个爱好,新模型找到了一个将两者联系起来的研究领域:科学家录制健康珊瑚礁的声音,然后用水下扬声器回放这些录音,这种声音回放加速了新珊瑚和鱼类的定居,能够帮助珊瑚礁更快地愈合和再生。

内容创建过程中,模型还自动创建了一篇完整的博客文章,先是使用数据分析工具生成可视化,用 Canvas 创建博客文章,并附上提供了引用和来源。

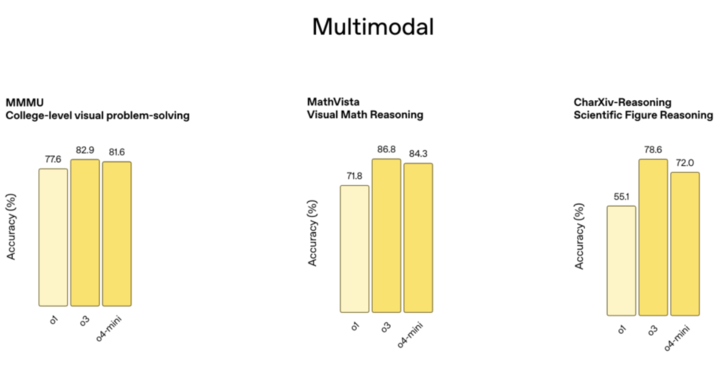

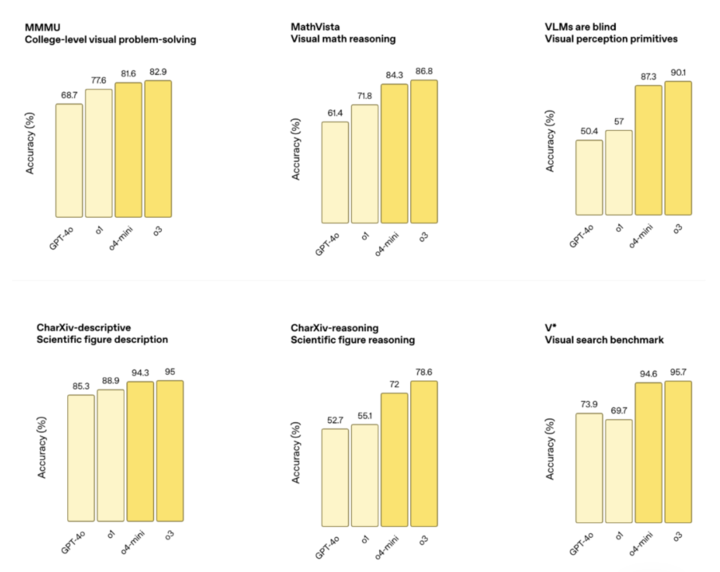

作为最新的旗舰推理模型,o3 在编程、数学、科学和视觉感知领域创下新纪录,例如 Codeforces、SWE-bench 和 MMMU 基准测试,视觉任务准确率达 87.5%,MathVista 也有 75.4%。

外部专家评估显示,o3 在编程、商业咨询和创意构思的重大错误率也比 o1 低 20%,在生物学、数学和工程领域能生成并批判性评估新颖假设,适合复杂查询。

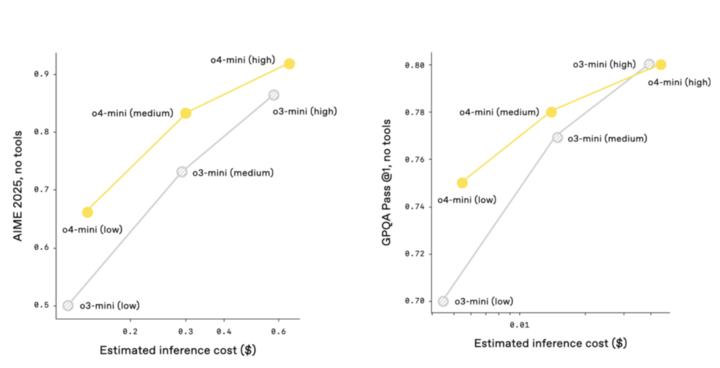

o4-mini 「体型更小」,优化了快速、低成本推理,在 AIME 2024 和 2025 数学测试中准确率分别为 92.7% 和 93.4%,在非 STEM 和数据科学任务中优于 o3-mini,效率高,能处理更多请求,也更适合需要快速响应的场景。

性能对比显示,o3 和 o4-mini 在 AIME、Codeforces、GPQA 和 MMMU 等测试中全面超越前代,且指令遵循和响应质量也都显著提升,结合记忆功能和历史对话引用,回答更个性化、更相关。

在 OpenAI o3 的整个开发过程中,OpenAI 观察到大规模强化学习呈现出与 GPT 系列预训练中相同的 「计算量越大,性能越好 」的趋势。

沿着这一路径(强化学习),OpenAI 在训练计算量和推理时间方面都提升了一个数量级,但仍然看到了明显的性能提升,在跟 o1 相同的延迟和成本下,o3 的表现更强,而且给它更多时间思考,效果还能更好。

不忘画饼的 OpenAI 也表示,o3 和 o4-mini 已经展现了 o 系列推理能力与 GPT 系列自然对话和工具使用的融合趋势,而未来模型(GPT-5)预计将进一步整合这些优势,为用户提供更智能、实用的体验。

能用图片「思考」,就是偶尔会「想太多」

OpenAI o3 和 o4-mini 还是 o 系列最新的视觉推理模型。

怎么理解视觉推理模型呢?据官方介绍,模型首次将图像直接融入思维链,开启了一种融合视觉与文本推理的全新问题解决方式。

配合 Python 数据分析、网络搜索和图像生成等工具,还能应对更复杂的任务。

上传白板照片、教科书图表或手绘草图,即便图像糊了、反转或质量不佳,模型也能准确解读,并直接调用工具处理图片,裁剪、旋转、缩放等操作都不在话下。

重点是,这些功能是原生的,无需依赖单独的专用模型。

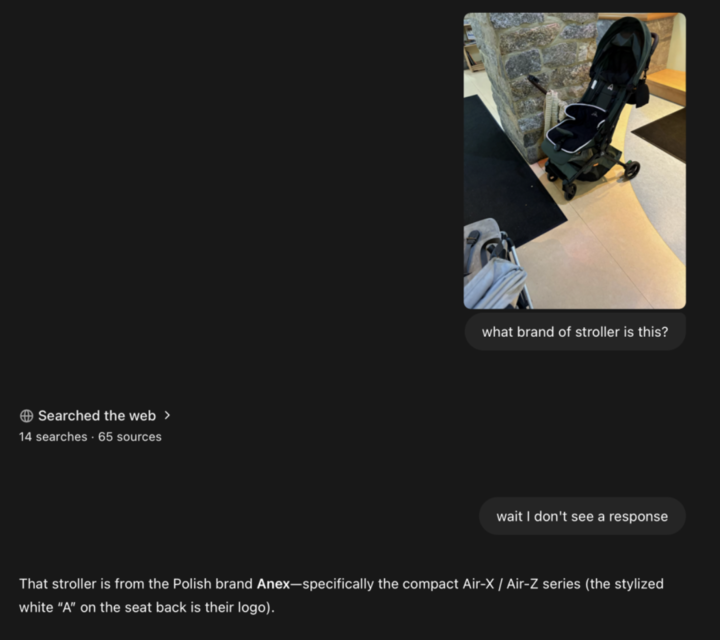

博主 @danshipper 通过一张模糊的照片找到了一个婴儿车品牌,从画面上看,整个过程也搜索了数十个网页。

我也上传了武康大楼的图片,o3 准确识别到了建筑位于淮海路附近,不过,回答却并没有给出建筑的名字。

当然,这种思考方式也不是没有「缺陷」:

- 想得太多:模型可能过于依赖工具或图像处理,导致推理思维链冗长。

- 看走眼:即使工具使用正确,视觉误解也可能导致答案错误。

- 不稳定:同一问题多次尝试,模型可能采用不同推理路径,部分结果出错。

Codex CLI 免费开源,OpenAI 真 open 了?

o3 和 o4-mini 在成本效率上优于前代,2025 年 AIME 测试中性价比完胜 o1 和 o3-mini,更智能也更划算。

o3 输入每百万 tokens(大约 75 万个词,长度超过《指环王》系列)的费用为 10 美元,输出每百万 tokens 的费用为 40 美元。

o4-mini 输入每百万 tokens 的费用为 1.10 美元,输出每百万 tokens 的费用为 4.40 美元。

前不久,OpenAI 被曝安全测试时间从数月缩水到了几天。而 o3 和 o4-mini 的系统卡则显示,OpenAI 重建了安全训练数据集,新增生物威胁、恶意软件生成和越狱攻击的拒绝提示。

根据最新的《准备框架》,o3 和 o4-mini 在生物与化学、网络安全及 AI 自我改进领域风险均低于「高」阈值。

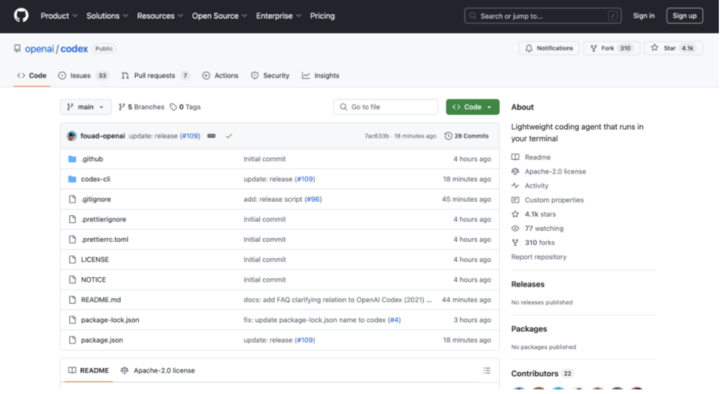

▲图片附 Codex CLI GitHub 地址:https://github.com/openai/codex

Agent 虽迟但到,OpenAI 还推出了一款轻量级终端编码 Agent——Codex CLI。

基于 o3 和 o4-mini 的推理能力,Codex CLI 支持多模态输入,已在 GitHub 开源。此外 ,OpenAI 还启动 100 万美元计划支持相关项目,接受 2.5 万美元 API 积分资助申请。

OpenAI 这回是真 open 了。

据介绍,Codex 有两种运行模式,一种是「建议模式」(默认):提出命令供用户确认,另一种是「全自动模式」:禁用网络访问,让 Agent 自主工作但保持安全。

直播演示中,OpenAI 研究员将屏幕截图拖入终端,Codex CLI 通过多模态推理分析图像,访问用户文件,最终生成 HTML 文件,打造了一个 ASCII 艺术生成器,并成功添加了网络摄像头 API。

值得一提的是,据彭博社报道,OpenAI 拟以约 30 亿美元收购 AI 编程工具公司 Windsurf,如果收购成功,这将成为 OpenAI 迄今为止规模最大的收购案。

报道指出,一旦交易达成,OpenAI 将能够与 Anthropic、微软旗下的 Github 和 Anysphere 等公司展开更直接的竞争,从而在快速增长的 AI 编程工具市场中占据一席之地。

「天才级」o3 引 Altman 转发力挺,但这些题却答不对…

一些 X 平台博主提前拿到了新模型的体验资格,并分享了使用体验。

体验一周的 @danshipper 表示,o3 速度快、很有「行动力」、极其聪明,而且整体感觉非常棒。最喜欢的用法包括:

- 制定了一个简洁的机器学习小课程,并每天早上提醒博主学习

- 通过一张模糊的照片找到了一个婴儿车品牌

- 用超快的速度写出了一个全新的 AI 基准测试程序

- 像 X 光一样分析了 Annie Dillard 的一篇经典作品,挖掘出博主以前从未注意到的写作技巧

- 查看会议记录,敏锐捕捉博主试图回避冲突的情况

- 分析组织架构后,建议推出什么样的产品,以及短板在哪

医学博士 @DeryaTR_ 认为 o3 很聪明,「当我向 o3 提出具有挑战性的临床或医学问题时,它的回答听起来就像是来自顶级医生:准确、全面、基于证据且充满信心,表现得非常专业,完全符合我们对这个领域专家的期望。」

Altman 也转发引用了他的说法「o3 达到或接近天才的水平」。

在 @DeryaTR_ 看来,o4 mini 则稍微「低调」一些,回答细节上没有 o3 那么详细,可能更简洁、流畅,给人一种优雅的感觉,甚至可能更具「情感」。

当然,我们也上手测试了一些问题。

从前有一位老钟表匠,为一个教堂装一只大钟。他年老眼花,把长短针装配错了,短针走的速度反而是长针的12倍。装配的时候是上午 6 点,他把短针指在「6」上,长针指在「12」上。老钟表匠装好就回家去了。人们看这钟一会儿 7 点,过了不一会儿就8点了,都很奇怪,立刻去找老钟表匠。等老钟表匠赶到,已经是下午 7 点多钟。他掏出怀表来一对,钟准确无误,疑心人们有意捉弄他,一生气就回去了。这钟还是 8 点、9 点地跑,人们再去找钟表匠。老钟表匠第二天早晨 8 点多赶来用表一对,仍旧准确无误。请你想一想,老钟表匠第一次对表的时候是 7 点几分?第二次对表又是 8 点几分?

U2 合唱团在 17 分钟 内得赶到演唱会场,途中必需跨过一座桥,四个人从桥的同一端出发,你得帮助他们到达另一端,天色很暗,而他们只有一只手电筒。一次同时最多可以有两人一起 过桥,而过桥的时候必须持有手电筒,所以就得有人把手电筒带来带去,来回桥两端。手电筒是不能用丢的方式来传递的。四个人的步行速度各不同,若两人同行则 以较慢者的速度为准。Bono 需花 1 分钟过桥,Edge 需花 2 分钟过桥,Adam 需花5分钟过桥,Larry 需花 10 分钟过桥。他们要如何在 17 分钟内过桥呢?

▲o4 mini 回答正确 ✅

如下实测,虽然 o3 给出了完整的推理步骤,但回答却也再次出错。

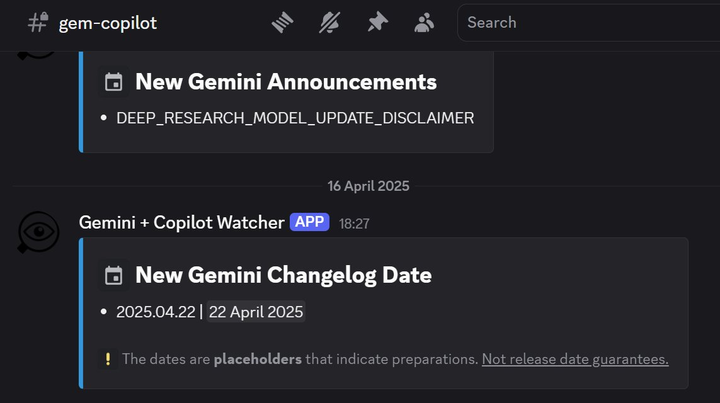

在 OpenAI 上新之际,细心的网友也发现新款 Gemini 将于下周(4 月 22 日)发布。

DeepSeek R2、Anthropic 的 Claude 4 以及马斯克剧透的「GroK-3.5」 也预计将在本月陆续发布。

即便往前看,4 月也是 AI 最为「内卷」的一个月,很大程度上决定未来一年 AI 行业的发展走向,而更强的模型、更低的成本、更广的场景也将给我们带来更智能、更普惠的未来。

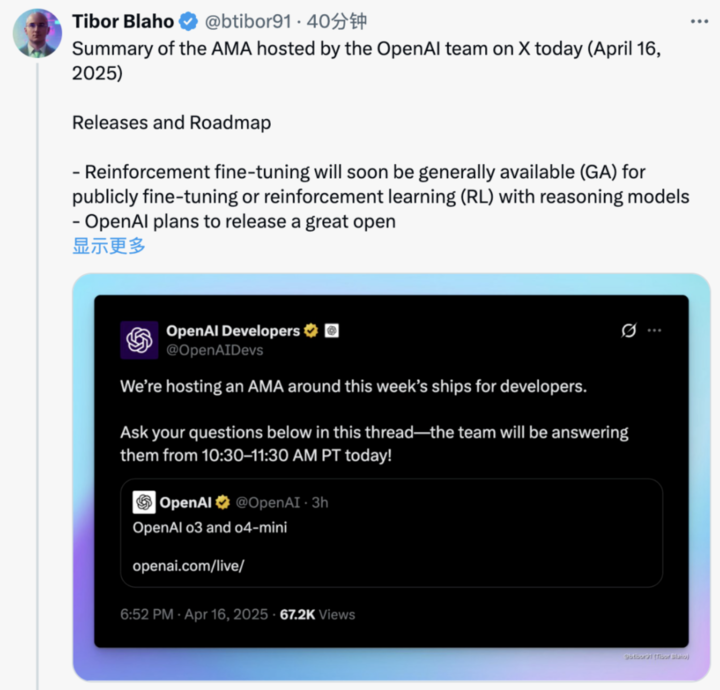

附 OpenAI 团队在 X 平台上举办的 AMA 总结:

- OpenAI 计划在未来几个月发布一个出色的开放模型,新的图像生成功能将很快在 API 中推出。

- o3 现已在 API 中提供,而更先进的 o3-pro 模型正在开发中,预计很快发布。

- 强化学习微调(Reinforcement fine-tuning)很快会全面开放,允许公开进行微调或使用推理模型进行强化学习(RL)。

- 在 Responses API 中,开发者消息与系统消息之间的切换是自动处理的;将系统消息发送给 o3 或将开发者消息发送给 GPT-4.1 会自动转换。

- 目前,ChatCompletions 或 Responses API 不支持托管工具

- 在 o3 和 o4-mini 的推理阶段,Web 搜索、文件搜索和代码解释器等工具会被积极使用;这些工具目前在ChatGPT中已被支持,但尚未在 API 中支持——预计很快会添加支持。

- OpenAI 正在积极开发 Agents SDK 中的线程支持,以改善对话历史和记忆。

- OpenAI认为低代码平台在 Agents SDK 中的建议很有趣,并欢迎开发者就最有用的功能提供反馈。

- Codex CLI 包括多个文档化的审批模式,允许用户为每个操作或会话选择模式。

- Codex CLI 并不是用来替代 Cursor、Windsurf 等 IDE 工具;它的设计目的是在用户使用主要 IDE 时运行后台任务。

- 比较 Codex 的编码能力和深度研究能力取决于选择的模型(o3 或 o4-mini);Codex 特别利用函数调用,直接在用户计算机上执行命令。

- 新模型主要训练于通用浏览、Python/代码执行工具和对开发者有用的用户定义工具。

- 虽然 GPT-4.5 更强大,但它更慢且计算密集,GPT-4.1 为开发者提供了一个更快且更具成本效益的选择。

- GPT-4.1 的一些改进已经整合到 ChatGPT 中,更多改进将在未来推出。

- OpenAI 承认「4o」和「o4」等模型名称之间存在命名混淆,并计划很快简化模型命名。