AI 硬件要真正走进生活,需要新的「引擎」

2025 年被视为 AI Agent 元年,包括 OpenAI 、Google、微软在内的科技公司都提出 Agent 将开始加入劳动力大军,甚至改变工作形态。

与此同时,Google 、OpenAI 这些以软件为主要产品的公司也纷纷开始推出更多智能硬件。

这两件事并非孤立的巧合,它们共同指向了一个清晰的信号。

在前几天火山引擎「Force 原动力大会」上,火山引擎大模型智能算法负责人吴迪认为,让 AI 能力变得触手可及,将助力 IoT 硬件和轻量级硬件的全面升级,整个硬件价值体系也将可能会被重新塑造。

在中国,火山引擎作为云和AI 服务平台,虽然并非传统的硬件制造商,但却用另一种方式参与到 AI 和硬件产品的融合中。全球前十的手机厂商中有 9 家都和火山引擎有深度合作,火山引擎的端云协同架构正在成为智能硬件的「大脑」和「神经」。

在我们跟从业者的沟通中发现,硬件厂商在和 AI 结合中普遍面临的挑战是,市场生态的碎片化以及高昂的开发成本。这也是一些 AI 硬件昙花一现,却始终无法成为用户常用设备的重要原因。

火山引擎在其智能硬件解决方案中反复强调的「原子化能力」和「端云一体化」理念,恰恰也切中了当前 IoT 设备AI化进程中的核心症结 ——如何打破端与云之间的壁垒,让 AI 能力更顺畅地流淌到每一个硬件终端。

海量的 AIoT 硬件已经成为 Agent 的重要入口,谁率先做好了设备端到端的响应,谁就能在这个方兴未艾的 AIoT 市场拔得头筹。

拆解火山引擎「原子能力」:AIoT 的工具箱

一个 3 岁的孩子抱着毛绒玩具,问它「为什么天空是蓝色的」,玩具立刻用童趣的声音回答,还能根据孩子脸上的表情调整语调——这不是科幻片,而是 Haivivi 这样 的 AI 玩具已经实现的场景。

这背后其实是火山引擎用「原子能力」组成的 AI 工具箱,这是火山引擎泛互联网行业解决方案负责人江南提出的概念。

江南认为,技术提供者应「以原子化和组件化的方式提供服务」,即把AI大模型的能力(如语音、语言、多模态等)拆分成标准化、可组合的API/SDK,供合作伙伴灵活调用。

原子能力不是孤立的功能点,而是「能力即服务」,不仅提升了合作的灵活性,也大幅降低了厂商的开发门槛,从而推动整个行业的创新和生态繁荣。

火山引擎这些原子能力就像乐高积木,为硬件厂商提供近乎「开箱即用」的智能化工具箱。

爱范儿梳理了火山引擎给智能硬件准备的「原子能力」:

- 豆包大模型 – 设备的「智慧大脑」

- 扣子(Coze)平台 – AI 应用的「快速孵化器」

- ASR/TTS技术 – 让设备「能听会说」的语音引擎

- RTC实时通信 – 连接云端与设备的「高速神经网络」

- VLM视觉语言模型 – 帮助设备「看懂世界」的视觉大脑

- Function Calling – 调用外部服务的「万能工具手」

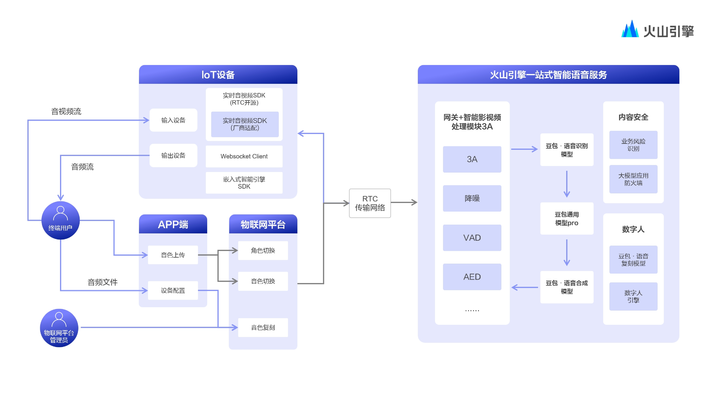

▲一图看懂火山引擎原子能力「工具箱」

在 AIoT 领域,豆包大模型扮演的角色远远不只是聊天机器人。除了能够识别用户的意图,还有不断变强的逻辑推理能力,使得硬件设备在面对复杂场景时能够进行一定程度的自主判断。

同时,豆包大模型对多模态交互的支持,意味着未来的智能设备将不再局限于单一的语音或文本输入,而是能够综合处理图像、声音等多种信息 ,这为实现更自然、更接近人类交流方式的人机交互奠定了基础。

例如,豆包最新的 Seed 1.6 Flash 模型作为轻量级的语言和视觉合版模型,能做到 1 秒输出 100 个Token,大大提升了端到端的响应速度 。

至于扣子这个 AI Agent 开发平台,让没有深厚编程背景的产品经理也能零基础快速搭建 AI 应用。它就像是提供了一套「一站式」的开发模板,大大缩短了从创意到产品的周期。

扣子的端插件能力特别值得关注 。它能让智能体与物理世界直接交互——比如让AI助手不仅能回答”今天天气怎么样”,还能主动帮你开启空调并调节到合适温度。这种能力让硬件从被动响应转向主动服务 。

在交流环节,ASR 语音识别和 TTS 语音合成技术负责让设备「能听会说」。火山引擎的 ASR 即使在嘈杂环境下也能精准识别指令,而 TTS 技术让机器的声音不再冰冷,变得更有「人情味」。涂鸦智能接入后,语音识别准确率提升了超过 20% 。

还有一个关键的是 RTC 实时通信技术,它像是连接设备与云端的”高速公路”,确保音视频数据能够低延迟、高稳定传输 。

这对 AI 玩具至关重要——当孩子问问题时,如果等待 3-5 秒才有回应,体验就会大打折扣。火山引擎通过优化,将响应时间压缩到 1 秒内,让对话变得像真人交流一样自然 。

火山引擎大模型智能硬件负责人邢孝慈指出,端到端的实时性能是 AI 智能硬件落地的最大技术挑战,尤其是在云端推理场景下,响应速度直接影响用户体验。

火山引擎通过端云一体化优化,大幅提升 AI 语音交互的响应速度,已实现语音实时对话,最快只需1秒,平均时间小于 1.5 秒。

而为了让设备「看懂世界」,VLM 视觉-语言模型让摄像头不仅能「看到」画面,更能「理解」内容。比如识别孩子的手势表情,或者分析图片内容并回答相关问题 。移远通信的全系智能模组都已接入这项能力,让终端设备可以无缝融合多模态 AI 功能 。

Function Calling 函数调用则像是万能遥控器,让 AI 能够主动调用各种外部服务——控制家电、查询天气、设置提醒等连贯操作都能一键搞定 。

火山引擎的这套方案真正的竞争力不是「原子能力」本身,而在于如何将这些能力有机整合。

江南告诉爱范儿,原子能力的开放使火山引擎能服务于整个硬件生态链,包括芯片厂、整机厂、终端品牌等,形成「云+端」一体化的赋能体系。

这样一个完整的端到端服务体系,覆盖从设备数据采集,到边缘计算处理,再到云端大规模推理的整个链条, 这种「一站式服务」与传统云服务商提供孤立 AI 接口的做法截然不同。

同时通过与乐鑫科技、博通集成、移远通信、广和通等芯片模组厂商的深度合作,火山引擎提供「硬件+算法+平台」的全套支持 。这种合作模式让硬件公司能够更平滑地将 AI 能力嵌入产品中。

与其说火山引擎是技术供应商,不如说它更像是站在硬件厂商背后的「AI 军师团」。它不仅提供技术,更重要的是将字节跳动在抖音等 C 端产品中验证过的 AI 技术和运营经验,像搭积木一样自由组合,支持给 B 端硬件企业 。

AIoT 产品的新浪潮

当然,真正的考验来自始终市场第一线,技术架构的骨骼需要落地产品才会有鲜活的血肉。火山引擎一直强调的「更强模型、更低成本、更易落地」,是否能真的让这些 AIoT 产品在市场中掀起波澜。

Haivivi 不再是过去那种只会简单重复预设语音的「智能玩偶」,它能够根据与孩子的长期互动,更准确地理解孩子略显稚嫩、甚至有时不太规范的语言表达,学习孩子的兴趣偏好,提供个性化的陪伴内容,甚至在孩子情绪低落时给予安慰与鼓励,因此受到不少家长和孩子的欢迎。

这其中的关键,是音视频智能互动设备解决方案。Haivivi 通过深度集成火山引擎的豆包语音大模型以及「扣子」进行 Agent 构建,打造出了一套完整的 AIoT 互动系统。

据 Haivivi 联合创始人高峰介绍,为了达到自然的交互效果,Haivivi 团队与火山引擎的工程师们在多个层面进行了深度优化。

例如,在语音交互的响应速度上,通过优化端云协同的链路,将从用户发出语音指令到玩具给出反馈的端到端延迟控制在了行业领先的水平,部分场景下可以达到 300 毫秒以内。

▲Haivivi 联合创始人高峰

这款 AI 陪伴玩具能够声情并茂地讲述各种有趣的故事,还可以充当英语陪练陪伴孩子练习口语,与孩子进行成语接龙游戏,在这些备受青睐的使用场景里,保障儿童在对话过程中的沉浸感至关重要。

与 Haivivi 这类直接面向 C 端消费者的品牌不同,涂鸦智能作为一个全球化的 IoT 开发平台服务商,他们与火山引擎的合作则更多地体现在如何帮助广大的开发者。

今年年初,火山引擎与涂鸦智能达成合作,将豆包大模型全面接入涂鸦 AI 云开发者平台,共同推进AI大模型及云原生技术在多场景的规模化落地,这就有点像 AIoT 市场的 App Store。

双方合作的一个重要发力点恰好也是 AI 玩具领域。开发者可以在涂鸦的平台上更为便捷地实现音频、视频、图像和文本等多模态AI能力的一站式整合与调用 。

这意味着,即便是中小型的玩具开发者,也能够以更低的门槛、更快的速度,为其产品赋予先进的 AI 交互功能,有机会孵化出更多像 Haivivi 这样自然有趣的爆款产品。

旧品类因为 AI 对体验的重塑不只有玩具,这些年打开率不断走低的电视也开始有了变化。

用户想在电视上找到某个明星主演的电影,需要层层点击遥控器,在复杂的菜单中穿梭。

现在,你只需说出「我想看 xx 的电影」,电视不仅能瞬间找到相关影片,还能智能生成专属海报墙,整个过程的响应速度控制在 1 秒以内。

创维研究院院长、酷开 CTO 郭尚锋在「Force 原动力大会」的分享中,强调了一个朴素却关键的观点:实时反馈才是用户高频交互的核心。

▲创维研究院院长、酷开 CTO 郭尚锋

上述的电视交互体验,酷开称之为「超级智能体」。背后是利用豆包大模型的语义理解和个性化生成能力,更好理解你的用户观影偏好,然后深度融合火山引擎的语音交互技术,实现自然流畅的对话,简化电视依赖遥控器层层点击的复杂交互模式。

这种个性化服务延伸到了教育、健康、生活服务等多个垂直场景,郭尚锋透露酷开的 AI 绘本馆能在 12 秒内生成个性化故事,用户日活率因此提升 60%以上。

如果说智能玩具和智能大屏是 AIoT 在存量市场的智能化升级,那么 AR(增强现实)眼镜则代表了 AI 与硬件结合,在开创增量市场、探索下一代个人终端的巨大潜力。

灵伴科技(Rokid)副总裁、XR 中心负责人王俊杰认为,AR 眼镜有望成为下一代个人信息终端,它能在三维世界实现信息交互效率和体验的巨大提升。

这个愿景的实现尤其需要空间计算和多模态 AI 的深度融合,目前 Rokid 已经全面接入豆包多模态 AI 大模型。

▲Rokid 副总裁、XR中心负责人王俊杰

Rokid 作为国内AR领域的领军企业之一,其与火山引擎的合作,则为我们揭示了AI在空间计算时代可能扮演的关键角色。

据王俊杰介绍,与火山引擎豆包大模型的联合研发,Rokid不 仅优化了其 AR 眼镜内置AI助手的数据链路,提升了语音识别的准确率和自然语言理解的深度,更重要的是,能够结合豆包大模型的多模态理解能力,更好地将AI分析结果与用户所处的真实物理环境进行融合与叠加,从而提升AR应用的综合体验。

例如,用户佩戴 AR 眼镜看到一幅画作,AI 助手不仅能识别画作信息,还能结合用户偏好推荐相关的艺术展览;或者在工业场景下,AR 眼镜可以实时识别设备故障,并将维修指南以三维模型的形式叠加显示在工人眼前。

从会「读懂」孩子情绪的智能玩具,到能预测用户需求的客厅管家,再到将虚拟与物理世界无缝融合的 AR眼镜,成熟的硬件市场,开始兴起一股 AIoT 产品的新浪潮。

构建 AI 时代的「新基建」

火山引擎在智能硬件上做的这些,在模型参数和算法迭代狂飙的今天,是一条有点不同的路线:它要做的,远不只是硬件的「技术供应商」,也不是单纯训练一个更会「考试」的模型,或者一个更会「聊天」的机器人。

在火山引擎的剧本里,AI 是要真正「动起来」,随着大量 AIoT 设备自然融入用户的生活,成为能感知、会思考、有温度的伙伴。

为了让 AI 融入更多低算力的终端设备上,他们甚至把端侧 SDK 压缩到仅 100KB 内存的低功耗设备里,让百元级硬件也能拥有「聪明大脑」 。

这背后,是对端云协同架构近乎苛刻地打磨,也是对成本控制的极致追求。当大模型推理成本被大幅降低,AI 才不再是少数巨头的「专属玩具」,而是真正有望「飞入寻常百姓家」 。

火山引擎最近也推出了 MCP 服务,那些在 AI 技术积累上还处于「新手村」的传统企业或初创团队,未来有望可以通过 MCP 服务,快速、便捷、低成本地为自家产品装上 AI 引擎,实现从「功能机」到「智能机」的一键升级 。如同邢孝慈在分享中提到的:

MCP 等新服务进一步降低整体开发门槛,并且提高智能化的上限,使得更复杂、更智能的 AI 体验能够广泛应用到各个行业

这种硬件和 AI 的融合,可不是简单地给个 API 接口就完事了,而是从「芯」到「销」的全链路服务:

从豆包大模型、RTC 实时通信这些底层技术「硬菜」,到扣子这样的 AI 应用「快手菜」开发平台,再到拉上博通集成、广和通这些芯片模组大厂一起优化,甚至还帮你对接电商渠道「带货」。

这种从底层技术到上层应用的完整生态闭环 ,这不是简单的业务延伸,更像是而是一次基础设施级别的重新定义。邢孝慈告诉我们,智能硬件正从「功能型」向「服务型」转变。

所以说,无论是软件还是硬件,火山引擎似乎都正试图构建 AI 时代的「新基建」。

在日新月异的 AI 洪流中,不只我们的工作方式会面临转变,在智能硬件市场很有可能也会迎来「重新洗牌」,开启一个全新的竞争格局。在这个崭新的赛道上,火山引擎已经在狂奔,更多厂商也正在入局。

我们或许也可以期待这些 AIoT 产品涌现后的新生活:多模态融合、端云协同的技术架构,以及基于 Agent 的自主服务能力,让智能硬件升级到下一个维度的「智能」:真正懂用户、更个性化、从被动转向主动服务。